SEO Projelerinde İlk Aşamada Neler Kontrol Edilmelidir?

Zeo’da SEO operasyon ekibimiz farklı takımlar halinde çalışıyor. “Gönüllüler Takımı” olarak SEO projesinde ilk olarak nelerin kontrol edilmesi gerektiğiyle alakalı bir rehber hazırlamak istedik. Bu yazımızda konuyla ilgili tüm görüşlerimizi bulabilirsiniz.

Crawlability (Taranabilirlik) ve Crawl Budget (Tarama Bütçesi) Optimizasyonu

Yeni bir SEO projesine başlamadan önce yapılması gereken en önemli işlem, sitenin botlar tarafından taranabilir durumda olup olmadığını analiz etmek. Aksi halde yaptığımız geliştirmelerin hiçbir önemi kalmıyor, maalesef.

Sitelerin arama motoru botları tarafından taranabilir durumda olup olmadığını kontrol etmek için neler yapabiliriz beraber bakalım.

Robots.txt Kontrolü

Robots.txt dosyası bir web sitesinin komuta merkezidir. Robots.txt dosyası oluşturmak; arama motoru isteklerini doğru yönettiğimizden emin olmamıza ve tarama bütçesini iyi bir şekilde optimize etmemize yardımcı olur.

Eğer web sitesinizde bir robots.txt dosyası yoksa nasıl oluşturulmasını gerektiğine “Robots.txt Dosyası Nedir, Neden Önemlidir?” içeriğinden ulaşabilirsiniz.

Halihazırda bir robots.txt dosyanız bulunuyorsa; arama motoru botlarının siteye erişebilir durumda olduğundan emin olmalıyız. (Tabii ki botların tarama bütçesini optimize etmek için kapattığımız URL pathleri, pdf dosyaları ya da parametrelerine erişimleri hariç.)

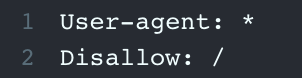

Eğer robots.txt dosyanız aşağıdaki komutlara sahipse, hiçbir bot sitenizi taramıyor demektir.

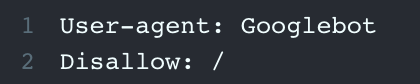

Eğer robots.txt dosyanız aşağıdaki gibi görünüyorsa, sadece Googlebot sitenizi tarayamıyor demektir.

Bu durumunda “Allow” komutu ile web sitesini arama motoru botlarının tarama isteklerine açmanız gerekir.

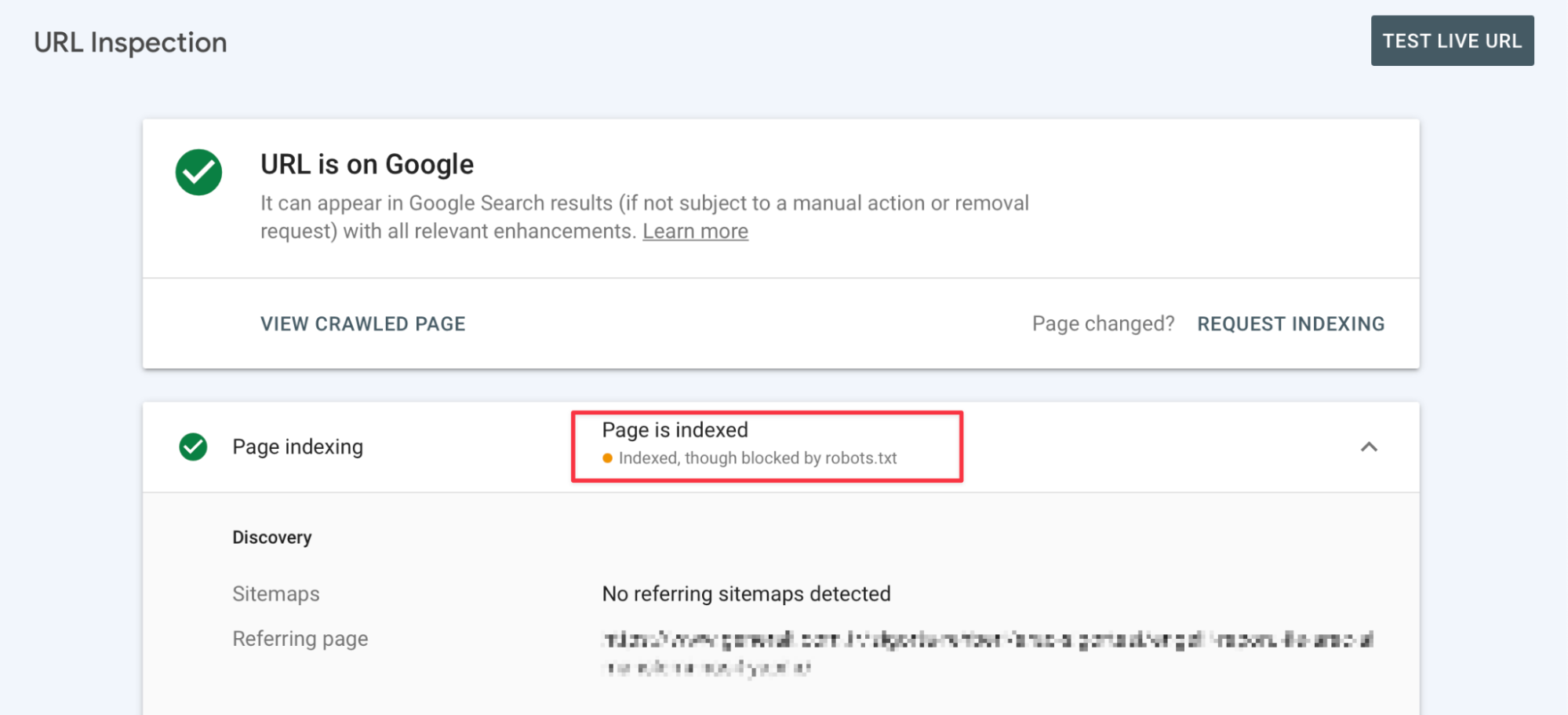

Google Search Console URL Inspection ve Crawl Stats

Robots.txt dosyasının dışında, Search Console aracının URL Inspection modülü ile spesifik bir URL’nin taranabilir durumda olup olmadığını da kontrol edebilirsiniz.

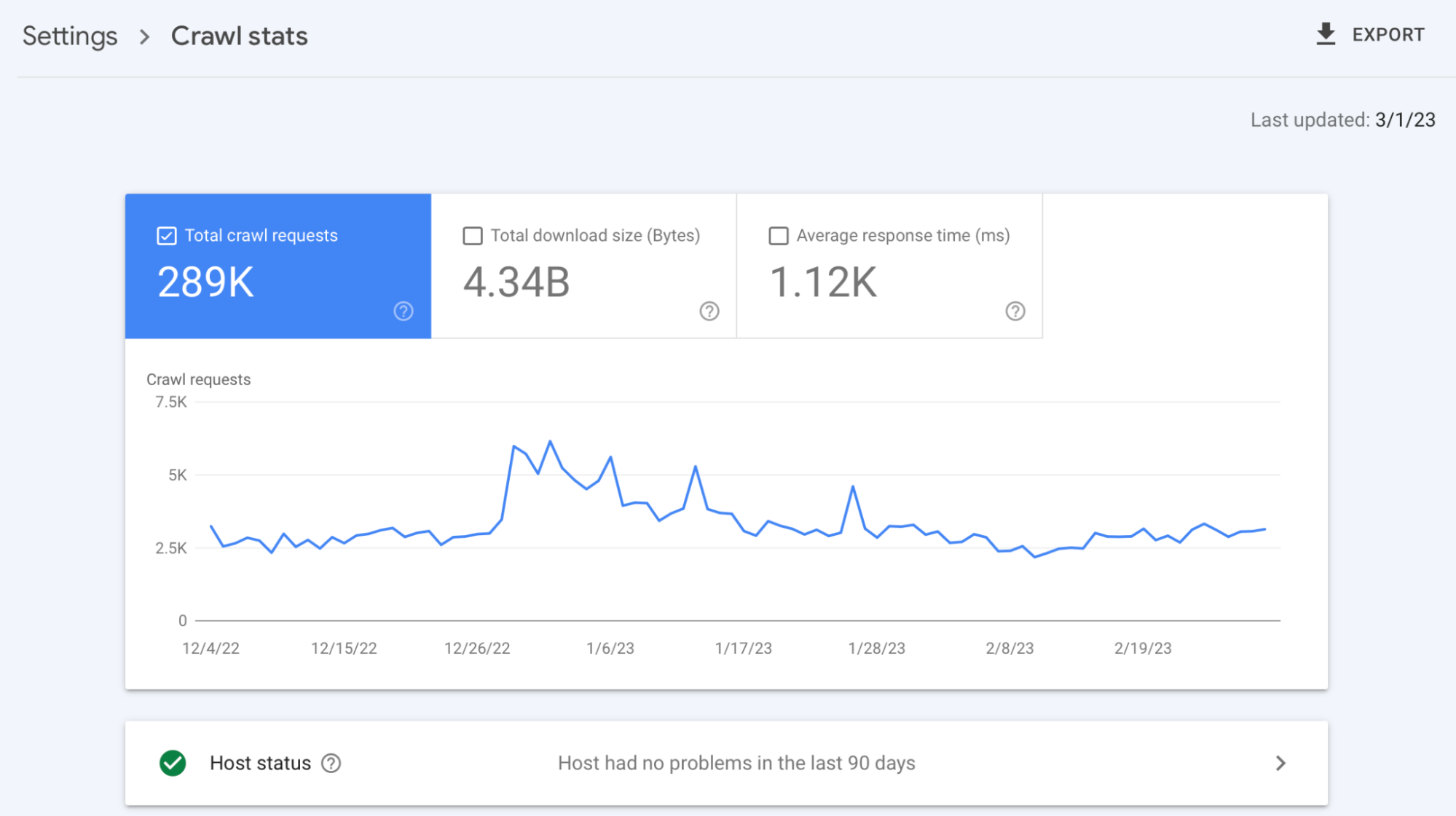

Ayrıca Search Console aracında yer alan “Crawl Stats” kısmından da web sitenize gelen tarama isteklerini kontrol ederek, web sitenizin taranabilir durumda olup olmadığını kontrol edebilirsiniz.

Sitenin arama motoru botları isteklerini engellemediğinden emin olduğumuzda ise bir site haritasının var olduğundan ve internal link kurgusunun web sitesinde bulunduğundan emin olmanız gerekiyor. Çünkü arama motoru botlarının o sayfayı taramadan önce keşfetmesi gerekir.

Eğer site haritasında ya da site içi linkleme kurgusunda yer almayan bir sayfanız varsa, mutlaka site haritasına eklemeniz ve site içi link kurgusuna dahil etmeniz gerekiyor. Aksi halde bu sayfanın keşfedilmesi ve taranması imkansıza yakın bir noktaya geliyor.

Ayrıca site içerisinde yer alan internal linklerin “rel=nofollow” olup olmadığının da kontrol edilmesi gerekmektedir. Nofollow etiketine sahip linklemeleri arama motoru botları genellikle takip etmez ve bu nedenle taramaz.

Eğer sitemizin taranabilir olduğundan eminsek, artık “doğru bir şekilde taranabilir” olduğundan emin olma vakti!

Taranabilirlik, tabii ki tüm sayfaların taranması demek değildir ve bunu gerektirmez. Crawl budget (tarama bütçesi) olarak bilinen fakat hepimizin ilk aklına gelen “bütçe” kelimesinden farklı anlama gelen bir sorunumuz var.

Bence Crawl budget’ı optimize etmek büyük, orta ya da küçük ölçekli tüm siteler için oldukça önemli. Googlebot, neden benim için önemli olan sayfaya istek atmak yerine, search sayfası gibi gereksiz bir sayfaya istek atsın ki? (Tabii ki benim için önemli sayfa search sayfası değilse.)

Crawl budget’ı optimize etmek tamamen sitenizle ya da stratejinizle ilgilidir.

Örneğin, etiket sayfaları web sitenizin aslında kategori sayfalarıysa ve bu sayfalardan oldukça fazla trafik elde ediyorsanız; o halde burada tarama bütçenizi olumsuz etkileyen bir durum söz konu olmayacaktır.

Tarama bütçesini optimize etmek için önce arama motoru botlarının hangi sayfaları tarayabildiğini bilmek oldukça önemlidir. Bu işlem için robots.txt aracında yer alan “Disallow” komutlarını inceleyebilir, sitede manuel incelemeler yapabilir ya da Crawl Stats aracını kullanabilirsiniz.

Manuel incelemelerde karşınıza çıkan ve robots.txt dosyası ile tarama işlemine kapatılmamış parametreli URL’leri, gereksiz URL path’lerini ya da kullanmıyorsanız arama gibi sayfaları tespit edebilirsiniz. Ardından eğer sayfalar indekslenmemiş ise robots.txt ile bu sayfaları, parametreleri vs. taramaya kapatarak tarama bütçenizi optimize edebilirsiniz.

Fakat bu sayfalar indekste ise önce sayfalara noindex ekleyerek, indeksten düşmelerini beklemeniz gerekiyor. Ardından robots.txt ile bu sayfaları taramaya kapatabilirsiniz.

Bu arada, noindex eklendiğiniz sayfaların hızlı bir şekilde indeksten düşmesini istiyorsanız; bu URL’lerin bulduğu bir site haritası oluşturarak arama motoru botlarının bu sayfalara ulaşmasını sağlayabilirsiniz.

Not: Yatırım tavsiyesi değildir!

Manuel incelemelerden istediğiniz sonuçları alamadınız ya da yeterli gelmedi diyelim ve Crawl Stats ile istek atılan gereksiz URL’leri nasıl tespit edebileceğimizi inceleyelim.

Crawl Stats bize Google botlarının sitemize attığı toplam istek sayısını, bu istekler toplamında indirdiği dosya boyutunu ve bu istekler sonucunda sitemizin botlara verdiği ortalama yanıt süresini bize gösteren muazzam bir araç.

Marifetleri bu kadarla sınırlı değil! İşte diğer marifetleri:

- Atılan isteklerin durum kodlarını,

- Hangi Google botunun ne kadar istek attığını ve hangi sayfalara attığını,

- Hangi URL’i yeni keşfettiğini, hangi URL’yi tekrar taradığını,

- Atılan isteklerin tipini (HTML, JS, CSS, Image vs.) bizimle paylaşan bir araç.

Tek kötü yönü ise sadece 1K URL paylaşması.

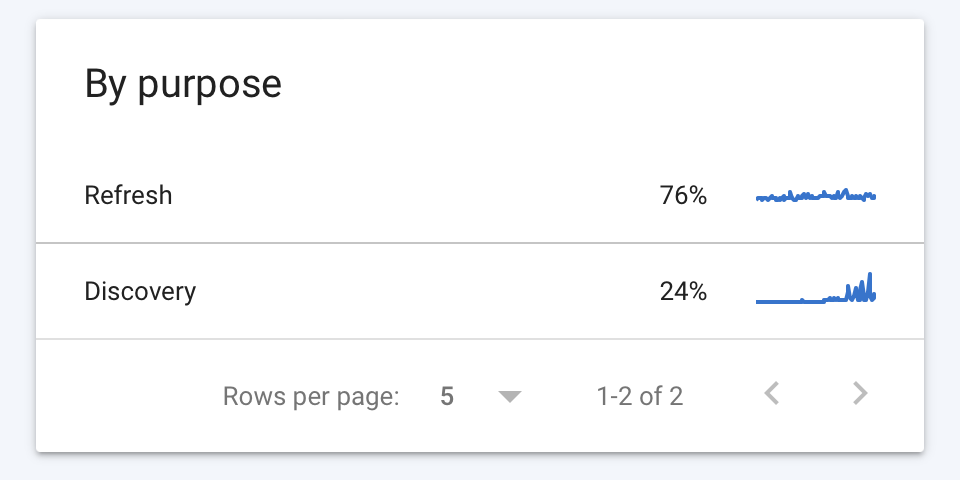

Tarama bütçesini optimize etmek için ilk olarak Crawl Stas aracının “By purpose” alanına bakalım.

“By purpose” başlığı altında Google botlarının yeniden istek attığı ya da ilk defa keşfettiği URL’leri görebiliyoruz.

Refresh ve Discovery başlığı altından tarama bütçemizi negatif yönde etkileyen yeni keşfedilmiş ya da yeniden istek atılan URL’leri inceleyerek, bir analiz yapabiliriz.

Örneğin, Googlebot’ları sıklıkla katma değeri düşük olan bir sayfa path’ine istek atıyorsa bu sayfaları tarama işlemine kapatmayı düşünebiliriz.

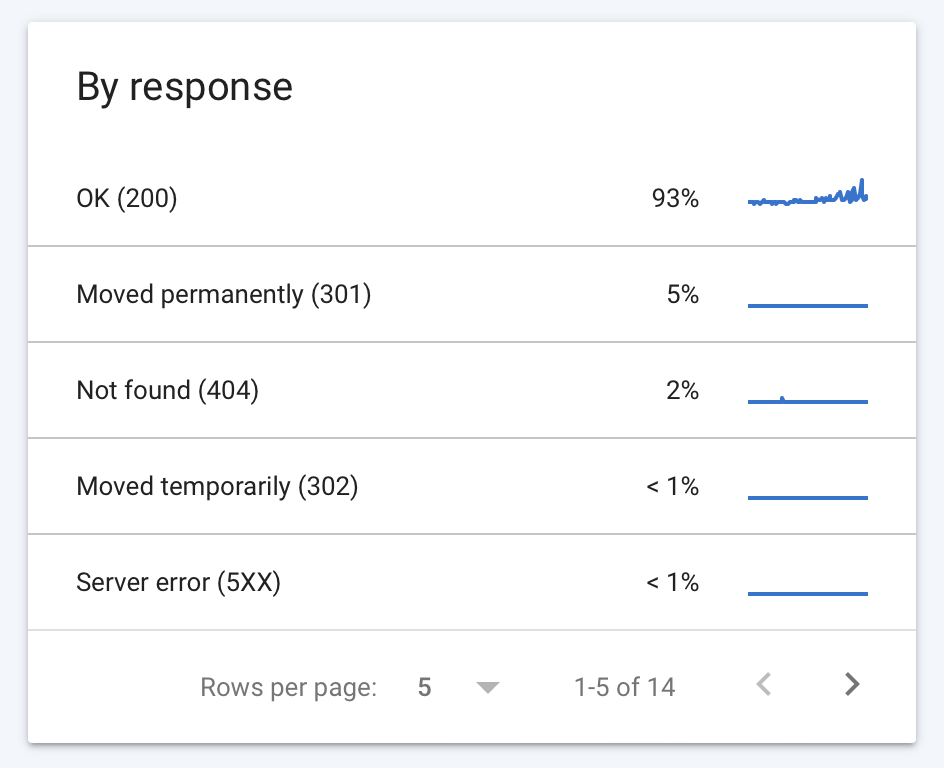

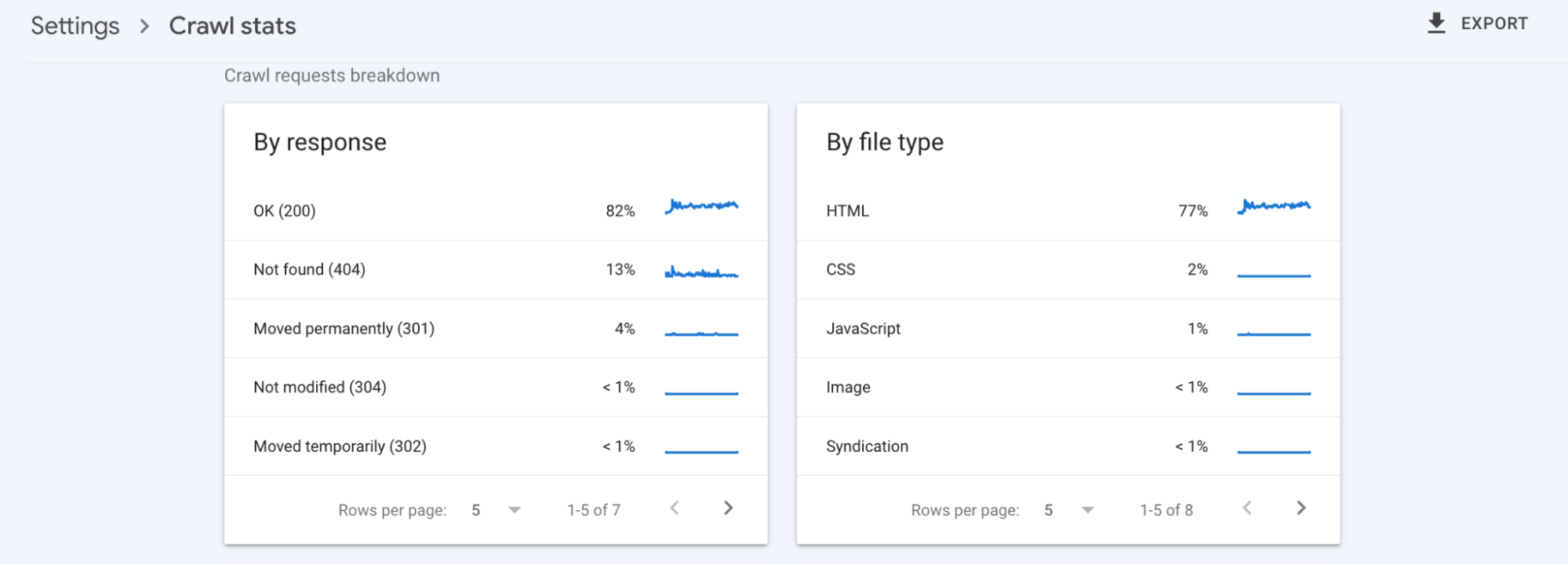

“By response” başlığı altında Google botlarının attığı istekler sonucunda URL’lerin çevirdiği durum kodlarını görebiliriz.

Unutmayın ki sadece gereksiz sayfalar tarama bütçesini olumsuz etkilemez.

Arama motoru botlarının çok fazla 301, 404 ve 500 gibi durum kodu çeviren URL’ye istek atması da tarama bütçenizi olumsuz etkiler. Hatta 200 durum kodu dışında durum koduna sahip sayfaların sayısının çok fazla artış göstermesi bazen sıralamalarınızı olumsuz etkileyebilir.

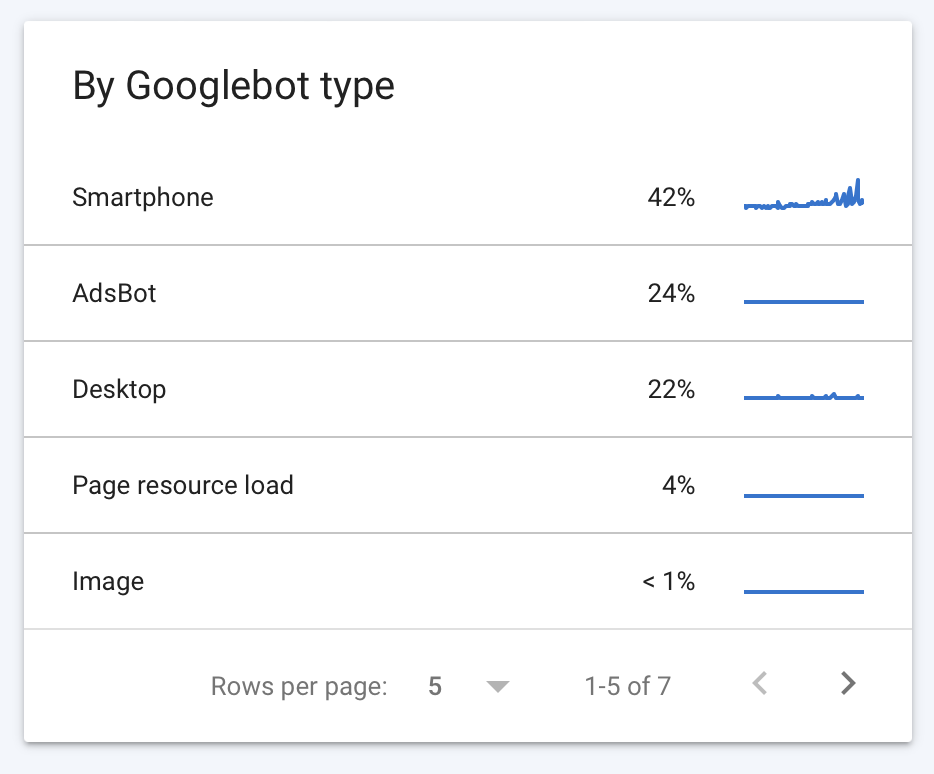

“By Googlebot type” başlığı altında ise hangi Google botlarının ne kadar istek sayısına sahip olduğunu ve ne tür sayfalara istek attığını görebiliriz.

Örneğin, eğer sitemizde sadece Ads için oluşturulmuş URL’ler varsa; bunları tespit ederek, bu URL path’ini robots.txt dosyası ile arama motoru botlarına kapatarak, sadece Google Adsbot’un taramasına açabiliriz.

Bu işlemi nasıl yapabileceğimize küçük bir örnek ile bakalım.

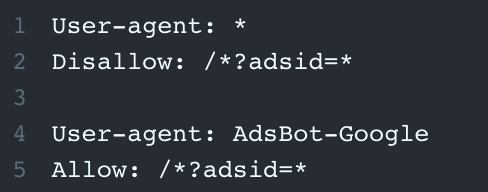

Ads için oluşturulmuş ?adsid= şeklinde parametresine sahip URL’lerimiz olduğunu ve tüm botların taramasına açık olduğunu varsayalım.

Aşağıdaki robot.txt komutları ile bu parametreyi tüm arama motoru botlarının taramasına kapatarak, sadece Adsbot’a açabiliriz.

Bot’lar robots.txt dosyasını da yukarıdan aşağıya doğru tarayacağı için “Allow” komutu Adsbot için Disallow komutunu ezecektir.

Umarım, ilk aşamada taranabilirlik sorununu ve tarama bütçesi optimizasyonunu beraber çözebilmişizdir. :)

Proje Geçmişine Hakim Olmak için Search Console’u Analiz Etmek

Bir SEO projesi geldiğinde projenin geçmişinde neler olduğu projenin geleceğine yön vermek adına oldukça önem arz ediyor. Projenin Search Console ve Analytics erişimleri alındığında sitenin geçmişine hızlıca göz gezdirmek projeyi daha iyi anlamanıza ve herhangi olumsuz bir durum var mı ya da yaşanmış mı bunu görmenizi sağlayacaktır.

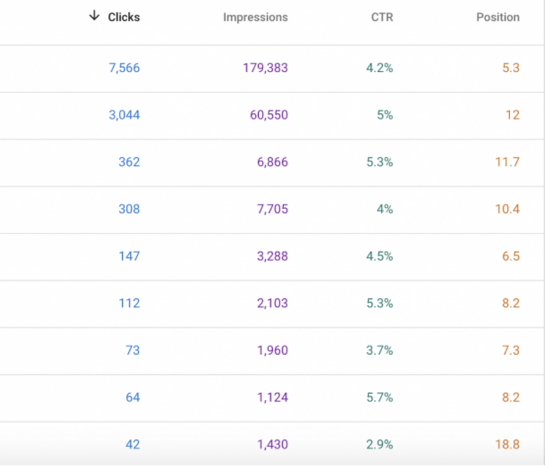

Öncelikle Search Console hesabında her zaman baktığımız gibi Search Results kısmından sitenin son 16 aydaki click, impression, ctr ve position değerlerine bakmak faydalı olacaktır. Site bu 16 aylık süreçte çok büyük bir düşüş/yükseliş yaşamış mı onu kontrol etmek, son ayları ondan önceki aylar ve ondan önceki yıl ile kıyaslayıp herhangi farklı bir durum var mı kontrol etmek yararlı olacaktır. Bu noktada son gelen Google Core Güncellemeleri de göz önüne alarak site bu güncellemelerden nasıl bir tablo ile ayrılmış onun da analizini yapmak Core Uptade’in içeriği ile birlikte sitenin durumunu daha iyi anlamanıza olanak sağlayabilir.

Organik trafik ve diğer kaynak verileri için tabii ki Google Analytics hesabını da kontrol etmek yararlı olabilir. Bunun yanı sıra Ahrefs, Semrush ve SearchMetrics gibi 3. parti araçlarla da sitenin geçmişini daha detaylı analiz etmekte de fayda var.

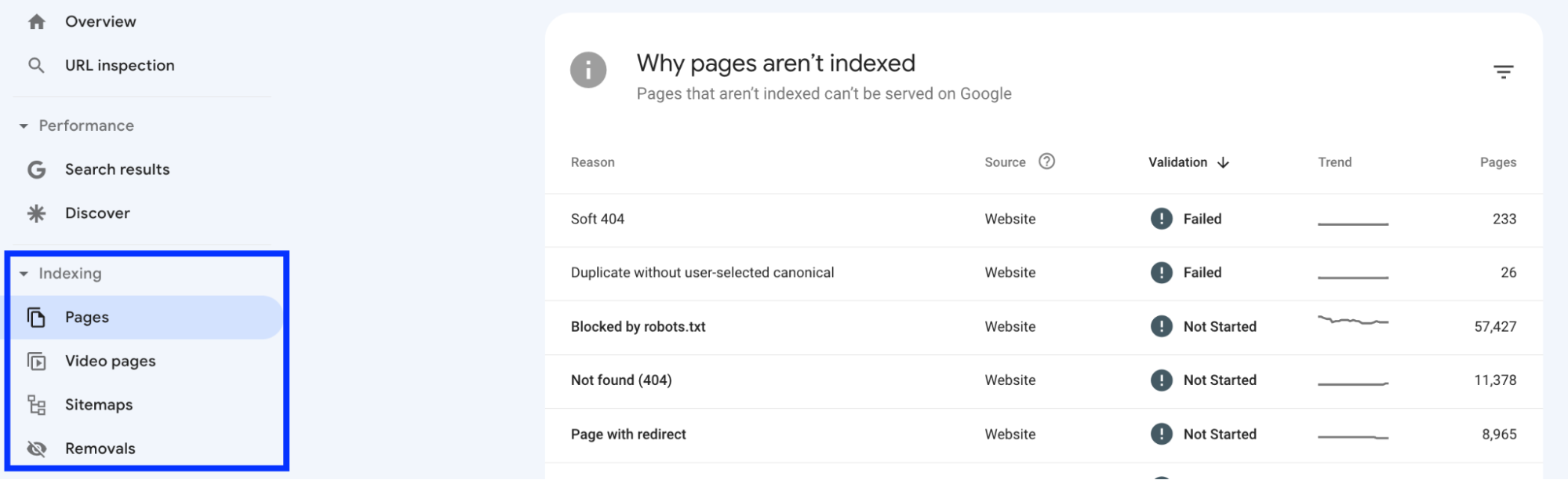

Trafik verilerinin yanı sıra özellikle Search Console hesabı bizlere çok daha farklı bilgiler veriyor. Indexing bölümündeki Pages sekmesinden sitedeki sayfaların son zamanlarda aldığı uyarıları incelemek ve buradaki sayfaların hangi sebeplerle indekse eklenmediğine bakmak projede -varsa- büyük sorunları yakalamaya da yardımcı olacaktır.

Sitemaps sekmesinden de önceden yüklenilen site haritaları varsa onları kontrol etmek ve robots.txt’in işaret ettiği site haritası ile tutarlı mı, farklı site haritaları var mı vb. gibi kontrolleri sağlamak da gerekiyor.

Indexing sekmesindeki Video pages bölümünde ise sitede var olan videoların durumu hakkında bilgi sahibi olabilirsiniz. Removals bölümünde ise sitedeki sayfalarda geçici kaldırma işlemleri yapılmış mı, eski içerik bölümleri var mı ve SafeSearch’de bir işaretleme var mı bunları kontrol edebilirsiniz.

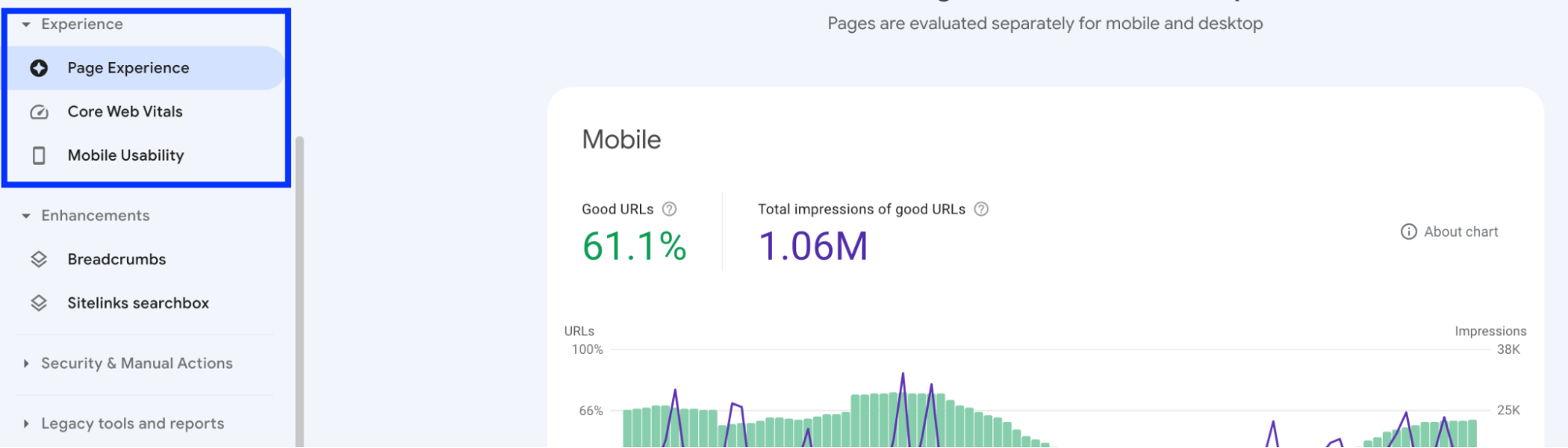

Experience sekmesinden ise sitenin yaklaşık son 3 aydaki sayfa deneyim raporunu inceleyebilirsiniz. Buradaki Core Web Vitals metriklerinin son 3 aydaki değişimine bakabilir ve olumsuz bir durum yaşanmış mı kontrol edebilirsiniz. Bunun yanı sıra Mobile Usability sekmesinde de mobil deneyimi kötü olan sayfalar var ise onları bulabilir ve nedenlerini hızlıca kontrol edebilirsiniz. Aynı zamanda bu sekmeden HTTPS raporuna bakabilirsiniz. HTTPS olmayan sayfalar var ise bu sekmeden rahatlıkla görebilirsiniz.

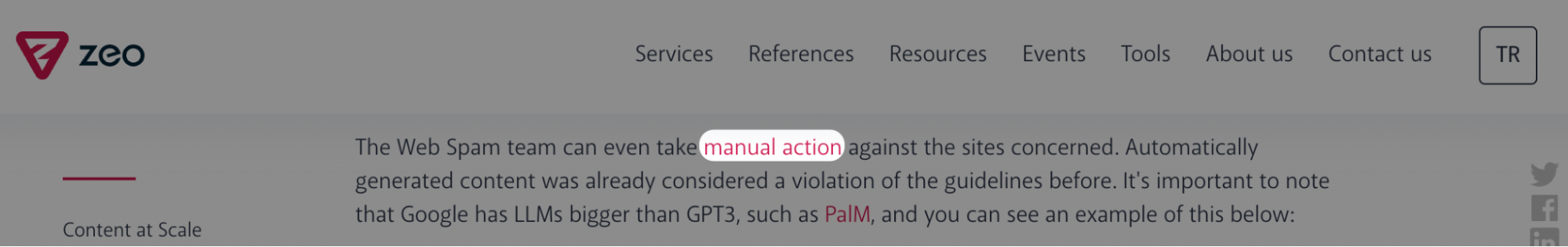

Diğer bir sekmemiz ise belki de en önemli sekmelerden biri olan Security bölümü. Site aktif olarak bir manuel işlem altında mı, önceki yıllarda herhangi bir manuel işlem altına girmiş mi, güvenlik sorununa sahip mi gibi sorular oldukça önem arz ediyor. Önceki yıllarda manuel işlem altına girmiş ise bunun nedenleri ve nasıl çözüldüğü, hangi zaman aralığını kapsadığı ve o zaman aralığında organik trafiğinin nasıl etkilendiğini detaylıca incelemek gerekiyor.

Security issues sekmesinde herhangi bir nedenden dolayı ihlali var ise bunun nedeni ne ve nasıl hızlıca çözüme kavuşturabilirizi projenin en başında konuşmak gerekiyor. (Hacklenmiş içerik, kötü amaçlı yazılım vb.)

Geçen sene gelen bir projemde Search Console’u kontrol ederken sitenin Manual Actions altında olduğunu gördüm. Nedenini incelediğimde birçok doğal olmayan backlink siteye geliyordu. Bu siteleri incelediğimde özellikle markanın test sitesinin taramaya kapatılmadığını ve birçok linkin bu site üzerinden gelmiş olduğunu tespit etmiştim. Bunun yanı sıra 500’e yakın farklı spam siteden aynı içerik ve aynı kelime üzerinden birçok link gelmekteydi. Bu noktada hızlıca test sitesini taramaya kapattık ve zararlı link analizi ile tüm linkleri reddettik. Ardından Google’a bu durumu bildirdik ve Manuel işlem hızlıca kalkmış oldu.

Link sekmesinde ise hem internal linkleri hem de external linkleri görebiliyoruz. Bu noktada bize link veren sitelerin analizini de hızlıca buradan ve 3.parti araçlardan yardım alarak yapabiliriz.

Son olarak Settings bölümünden sitenin Crawl analizlerine ve mobil öncelikli taranıp taranmadığına ulaşabiliriz. Crawl stats sekmesi özellikle tarama bütçesi açısından bize bir insight verebilir. Google botlarının sitemize çoğunlukla hangi tip bot kullanarak geldiğini, en çok hangi durum kodları ve hangi dosya türleriyle karşılaştığını hızlıca kontrol edebiliriz. Ekstra olarak son 3 aylık dönemde toplam crawl sayısı isteğine ve sunucu yanıt süresi ortalamasına da bakabiliriz. Buradaki hızlıca kontroller aslında sitenin var olan ve geçmişte yaşadığı sorunları da bizlere gösterecektir.

Yukarıda bahsettiğimiz mobil öncelik durumu da site için kritik bir konu aslında.

Zeo’nun MFI aracı ile sitemizi hızlıca kontrol edip sitenin mobil ve masaüstü versiyonları arasında içerik, meta etiketler, görseller ve link sayıları bakımından farklılıklar var mı bunlara bakmamız da proje ilk geldiğinde önemli olacaktır.

Internal Links (Site İçi Linkler)

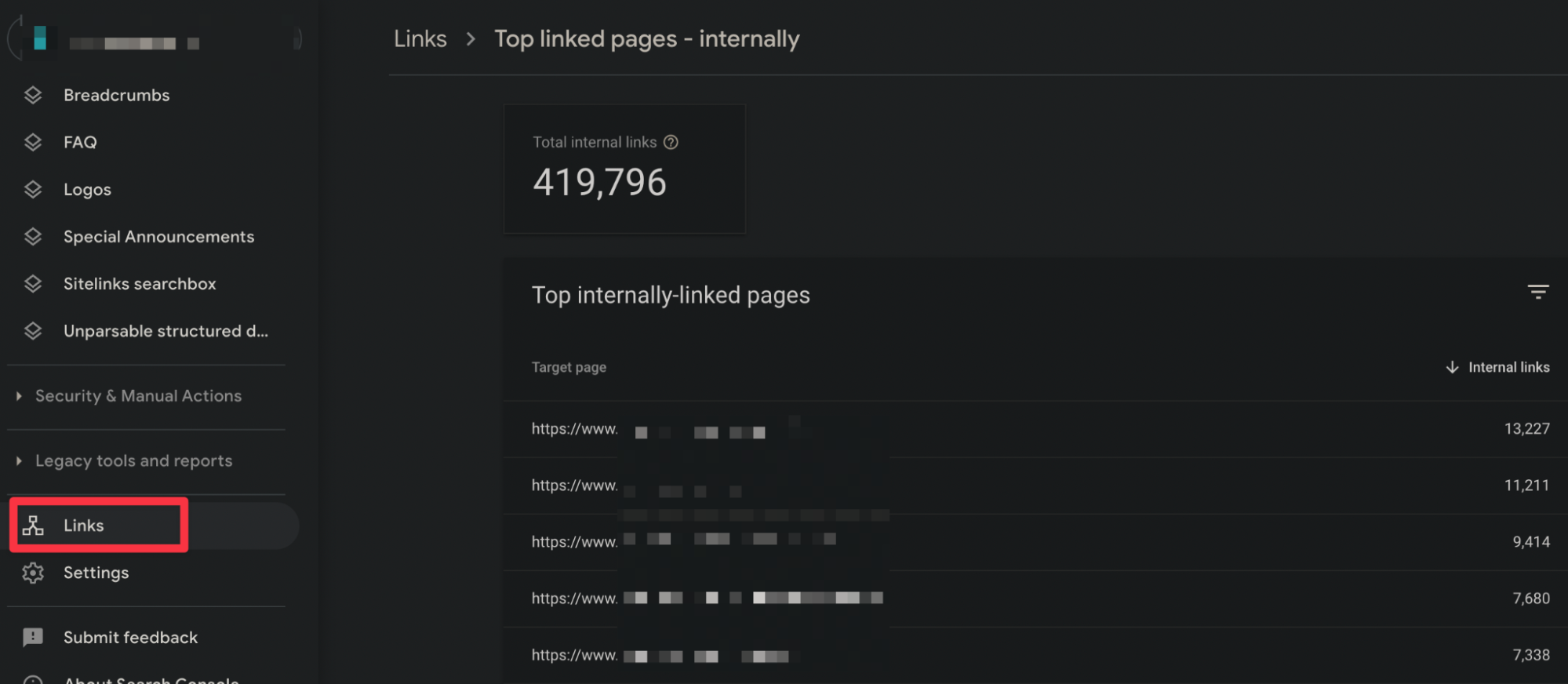

Internal link yapısını SEO projesi ilk başladığında kontrol ederek sizin için çok önemli sayfalarınızdan daha fazla gelir elde edebilirsiniz. Konumuz kontrol aşaması olduğu için basit ama etkili bazı önerileri iletmeye çalıştım. Elbette gelecekte Topic Clusters gibi konulara da özen gösterebilirsiniz. Google Search Console ile sitenizi doğruladıktan sonra Google’a göre sitenizde en çok link verilen sayfaları aşağıdaki kısımdan öğrenebilirsiniz:

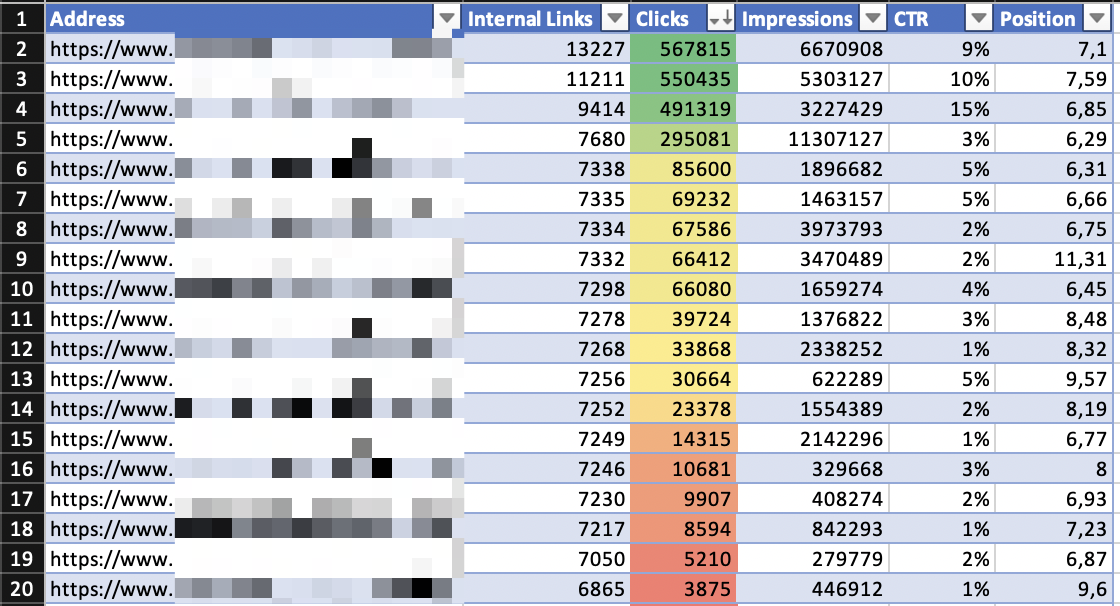

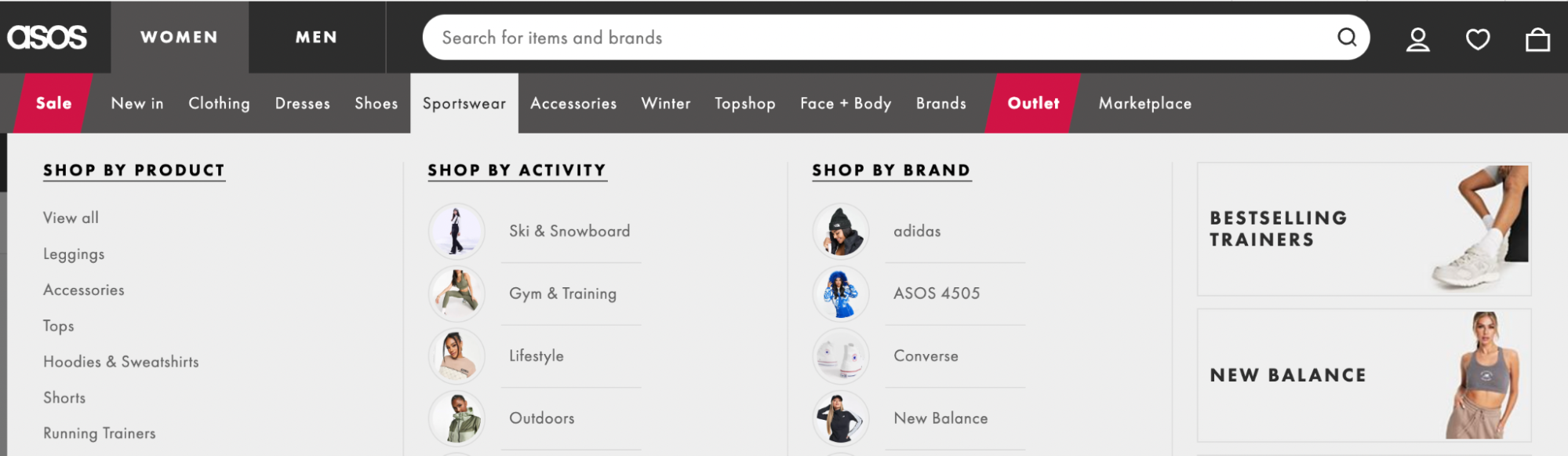

Bu sayfaları export ile indirdirip ne kadar organik trafik aldıklarını Search Console API kullanarak öğrenebilirsiniz. Site içerisinden çok fazla linklenen; ancak çok az click ya da impression elde eden sayfaları bu sayede tespit edip daha fazla iç linklendirme kurgularıyla aksiyonlar alabilirsiniz. Engellenmesi gereken sayfalar varsa robots.txt yardımıyla taramaya engelleyebilirsiniz:

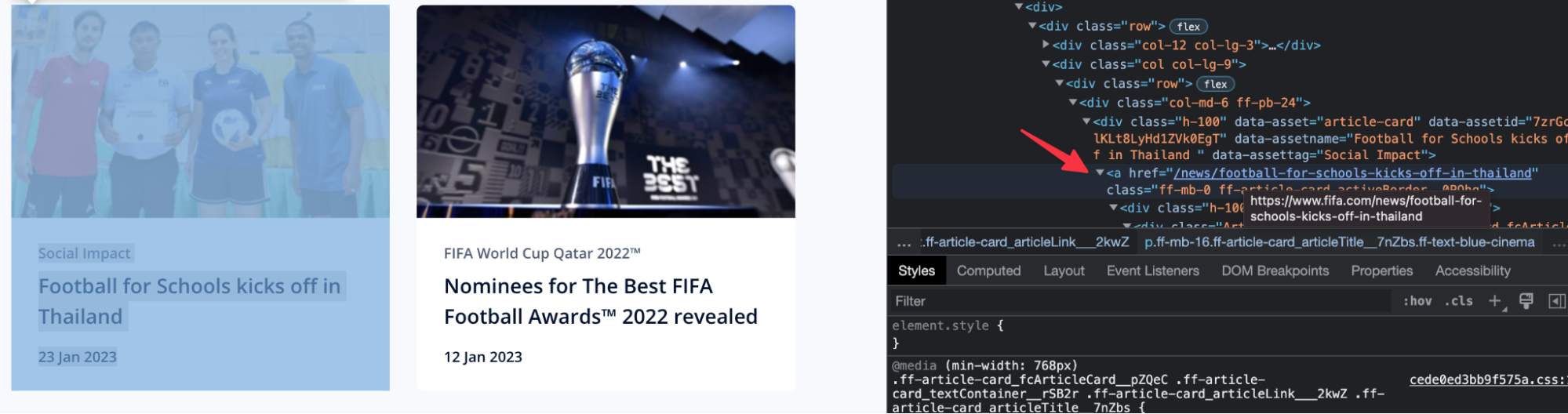

En sık gördüğüm eksikliklerden birisi de özellikle Javascript tabanlı sitelerde internal linklerde “onclick” ile linklerin verilmesi. Google, bu linklerin a href ile verilmesini öneriyor, bu yüzden iç link yapısında bu tür kullanımları mutlaka test etmenizi öneririm:

Site içi bağlantılarda kullanılan anchor text’ler kullanıcılara gidecekleri sayfa hakkında çok net ifadeler vermelidir. Örneğin manuel işlem ile ilgili bir konuya atıfta bulunuyorsanız konuyla ilgili Google cezaları sayfamızı ziyaret edebilirsiniz gibi kullanımlar çok sağlıklı olacaktır. SEO projelerinde ilk etapta bu kullanımlara da dikkat edebilirsiniz.

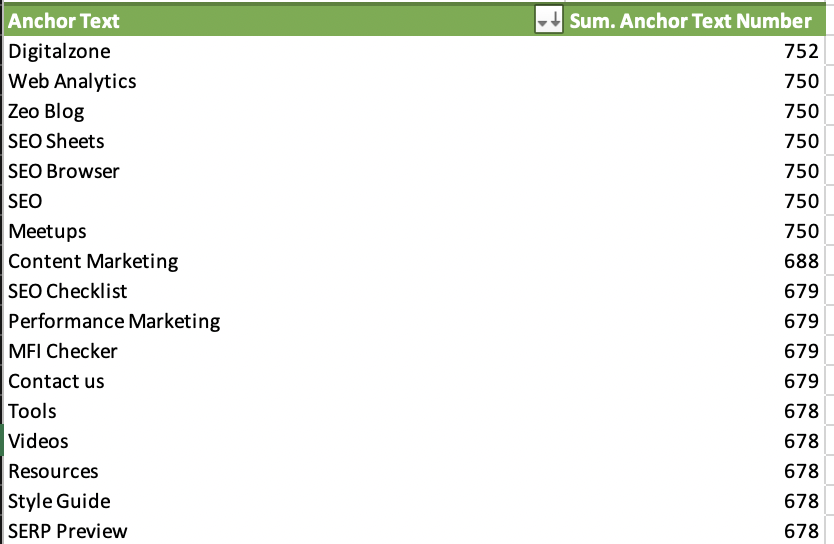

Internal linklerin anchor text kısımlarını analiz edip site içerisinde verilen anchor text sayılarını kontrol edebilirsiniz. Sitelerde ana sayfa, siteadi, siteadi logo gibi anchor text’lerin fazla olması gayet normal. Burada özellikle “buradan” gibi tam olarak sayfa hakkında bilgi vermeyen anchor text’lere göz atarak optimizasyon yapabilirsiniz. Aşağıda Zeo’nun belirli URL sayısına kadar taranan sayfa sayısının anchor text dağılımını görebilirsiniz:

“Bale ayakkabısı” kelimesiyle “kamp sandalyesi” sayfasına link vermek gibi hataların da önüne geçilmesi sayfaların performansı açısından faydalı olacaktır.

Site içerisinde header ya da footer gibi alanlar neredeyse her sayfada yinelendiği için burada yer alan linklerin bulk bir şekilde optimizasyonu SEO’ya etki olarak çok daha öncelikli olmalıdır. Örneğin e-ticaret siteniz var ve menüde kategorileriniz 301 ile yönlenen URL’lerden oluşmakta. Haliyle Google’ın yönlendiğiniz sayfaların final URL’lerini bulması zor olacaktır. Bundan dolayı ilgili alanlarda önemli sayfalarınızın (özellikle Search Console’a göre top 100 içerisinde yer alan) site içerisinde final URL’lerinin yer aldığını teyit edebilirsiniz:

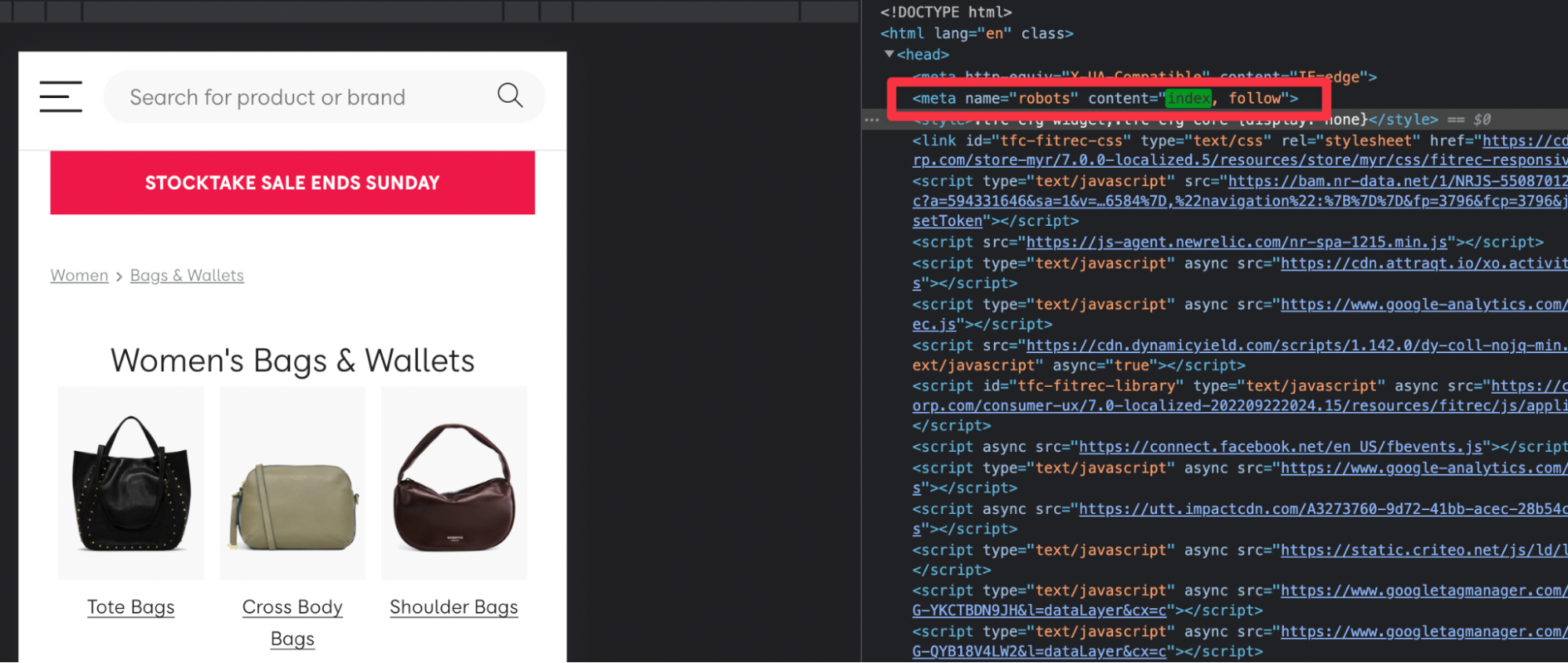

Değerli sayfalarınızın taranabilmesinin yanı sıra “noindex etiketi” ile dizin kapsamı dışında bırakılmadığını da kontrol etmelisiniz. Site içi link kurgusunu her ne kadar verimli kullansanız bile önemli sayfaların indekslenmemesi sitenize organik kanaldan ziyaretçi getiremeyecektir. O yüzden mutlaka önemli sayfalarınızın indekslenebildiğini tekrar teyit edin:

İçerik Optimizasyonu

İçerik üretmenin ne kadar önemli olduğunu hep söyleriz. Fakat en az içerik üretmek kadar önemli bir konu daha var: Mevcut İçeriklerin Optimizasyonu.

Özellikle de yeni bir projeye başlayacağınız zaman, mevcut içeriklerinizin durumunu gözden geçirmeniz hayli önemli. Peki, ''mevcut durumu gözden geçirmek'' derken aslında ne demek istiyoruz? Gelin, birlikte daha yakından inceleyelim.

Mevcut İçeriklerin Optimizasyonu

Bir içeriği ürettikten sonra onu unutmak olmaz. Zira siz içeriğinizi unutursanız, içeriğiniz de sizi unutur. Bir daha size asla yeterli katkıyı sağlamaz. Unutmayın ki üretim aşaması ne kadar önemliyse, içeriğinizin performansını takip edip buna göre optimizasyon sağlamak da o kadar önemli!

Özellikle web sitenize herhangi bir trafik kazandırmayan, hiç tıklama almayan, satın alma yolculuğunda hedef kitlenize hiçbir aşamada eşlik etmeyen, backlink getirmeyen, arama motorlarında üst sıralarda bulunmayan veya marka bilinirliği yaratma konusunda hiçbir faydası olmayan bir sürü içeriğiniz olabilir. Önceliğiniz, bu ''yetersiz'' içerikleri tespit etmek ve onları optimize etmek olmalıdır.

Teşhis

İlk olarak, yeterli verimi alamadığınız içeriklerin tespiti için Google Search Console ve Google Analytics gibi iki önemli aracı kullanabilirsiniz. Örneğin, Search Console'da performans sayfasının sunduğu verilere göz atabilir, buradan ilgili metrikleri ve zaman aralıklarını seçerek trafik alamadığınız, sıralama düşüşü yaşayan, tıklama düşüşüne maruz kalan içeriklerinizi kolayca tespit edebilirsiniz.

Zaman aralığını da seçerek bu değişimlerin ne kadarlık bir süre içinde gerçekleştiğini öğrenebilirsiniz. Örneğin, son 3 ayda bir içeriğiniz ciddi trafik kaybetmiş ve sıralamada epey geriye düşmüş diyelim. Bu aşamada Ahrefs ve SEMrush gibi araçları da kullanarak sizin düşüş yaşadığınız dönemde yükseliş yaşayan rakiplerinizi görebilir, onlardan neyi eksik yaptığınızı kolayca tespit edebilirsiniz.

Peki, bu tür verim alamadığımız içerikleri tespit ettikten sonra ne yapmalıyız? Eğer istediğiniz dönüşümü alamadıysanız o içeriğiniz bir şeyleri yanlış yapıyor demektir. Dolayısıyla eksik noktalara gerekli teşhisi koymalı ve uygun tedaviyi uygulamalısınız.

Dilerseniz, daha fazla vakit kaybetmeden tedavi aşamasına, yani adım adım bu içeriklerimizi nasıl optimize edeceğimize geçelim.

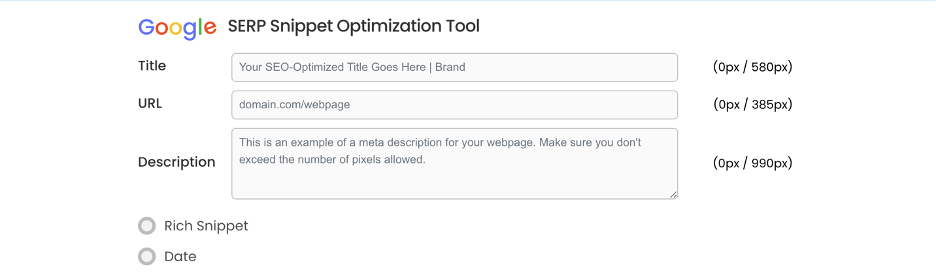

1. Meta Title ve Description Optimizasyonu

Meta title bir sıralama kriteri, bu yüzden title kurgularımız oldukça önemli. Sadece title optimizasyonuyla bile daha fazla tıklama alabilirsiniz. Meta description ise bir sıralama kriteri olmasa da, potansiyel ziyaretçileri içeriğinize teşvik etmek açısından oldukça faydalı. Yeterli uzunlukta, ilgi çekici CTA içeren bir title ve description ile ziyaretçileri sayfanıza çekebilir, eskisinden çok daha iyi dönüşüm oranları elde edebilirsiniz. Title ve description ayarlamaları için Serpsim aracını kullanabilirsiniz.

2. URL Optimizasyonu

Her zaman arama motoru dostu bir URL yapısı kullanmanızı tavsiye ederiz. Eğer yeterli verimi alamadığınız sayfanızda/içeriğinizde doğru bir URL yapısı kullanılmamışsa, bunu düzeltmeniz faydalı olacaktır. Mümkünse anahtar kelimenizi içeren, Türkçe karakter içermeyen, kısa bir URL yapısı tercih etmelisiniz. Yanlış URL yapısına sahip sayfalarınızı ise Screaming Frog veya Lumar gibi bir araç kullanarak tespit edebilir, buna göre bir aksiyon alabilirsiniz.

3. Anahtar Kelime Optimizasyonu

Çoğu kişi anahtar kelime stratejisini hala 2010 yılındaymışız gibi kurgulamaya devam ediyor. Ancak o yıllar çok geride kaldı. Siz de değişime ayak uydurmalı ve kendinizi güncellemelisiniz. Tıpkı içeriklerinizi güncellemeniz gerektiği gibi. Aksi takdirde ne kadar uğraşsanız da içeriklerinizden gerekli faydayı sağlayamayabilirsiniz. Örneğin, bazı içeriklerinizin sadece aşırı anahtar kelime kullanımı nedeniyle dahi geriye düşebildiğini biliyor muydunuz?

Bu yüzden mevcut içeriğinizi incelerken, anahtar kelimeleri nasıl kullandığınıza dikkat edin. Gereğinden fazla anahtar kelime kullanmış ve içerikte doğallığı kaybetmiş olabilirsiniz. Artık arama motoru botları o kadar akıllı seviyeye geldi ki, bir kelimede sıralama almak için o kelimenin direkt olarak içeriğinizde geçme zorunluluğu dahi bulunmuyor. Botlar aradaki alaka düzeyini çok iyi kurabildiği için bazı kelimeleri bağdaştırıp içeriğinizi ilgili kelimelerde de sıralamaya çıkarabiliyor.

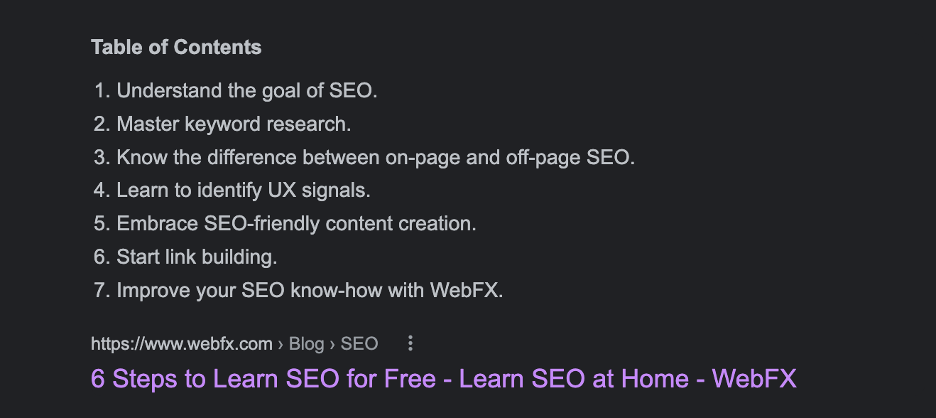

Örneğin, hedeflediğimiz anahtar kelime ''how to learn seo'' olsun. Google'da böyle bir arama yapalım. Featured snippet'ta karşıma bir site çıktı.

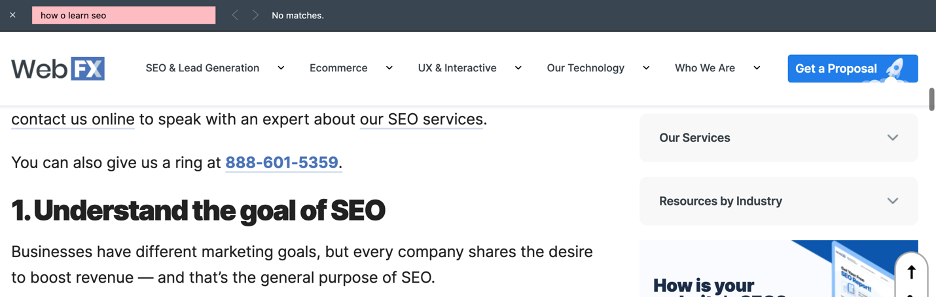

Title'da direkt olarak ''How to Learn SEO?'' yazmıyor. İçeriğe tıklıyoruz ve içeriğimizde ilgili anahtar kelimenin kaç kere geçtiğine dikkat ediyoruz.

İçerikte ''how to learn seo'' diye bir arama yaptım ve karşıma sıfır sonuç çıktı. Yani içerikte hiç ''how to learn seo'' geçmemiş. Ama Google'da ''how to learn seo'' diye bir arama yaptığımda, bu site hemen karşıma çıktı. İşte tam olarak bundan bahsediyorum. Artık ''anahtar kelimeyi şu oranda kullanmalısın, şu kadar kez geçirmelisin, bolca anahtar kelimeyle içeriği doldurmalısın'' gibi durumlar söz konusu değil. İçeriklerini doğal bir kurguda oluşturan ve gerçekten kullanıcıya gerekli bilgiyi veren içerikler öne çıkıyor. Botlar zaten aradaki alakalılık düzeyini çok iyi anlayabildiği için, benzer aramalarda da kaliteli içeriği ön plana çıkarabiliyor.

İçerikte ''how to learn seo'' diye bir arama yaptım ve karşıma sıfır sonuç çıktı. Yani içerikte hiç ''how to learn seo'' geçmemiş. Ama Google'da ''how to learn seo'' diye bir arama yaptığımda, bu site hemen karşıma çıktı. İşte tam olarak bundan bahsediyorum. Artık ''anahtar kelimeyi şu oranda kullanmalısın, şu kadar kez geçirmelisin, bolca anahtar kelimeyle içeriği doldurmalısın'' gibi durumlar söz konusu değil. İçeriklerini doğal bir kurguda oluşturan ve gerçekten kullanıcıya gerekli bilgiyi veren içerikler öne çıkıyor. Botlar zaten aradaki alakalılık düzeyini çok iyi anlayabildiği için, benzer aramalarda da kaliteli içeriği ön plana çıkarabiliyor.

Bu yüzden halihazırda ürettiğiniz ve yeterli verim alamadığınız içeriklerinize bir de bu gözle bakın. Keyword stuffing yapılmış mı? Anahtar kelime çok mu kullanılmış? İçeriğiniz gerçekten rakiplerinize göre kaliteli mi? Bu gibi sorulara vereceğiniz cevaplar, daha kaliteli bir içeriğin temelini oluşturacaktır.

4. Search Intent

İçeriklerinizi optimize ederken kullanıcıların arama niyetini göz önünde bulundurmak son derece önemlidir. Bu yüzden mevcut içeriklerinizin arama niyeti göz önünde bulundurularak oluşturulup oluşturulmadığını mutlaka dikkate almalısınız. Örneğin, ''kalori ihtiyacı hesapla'' diye arama yapan bir kullanıcının karşısına sadece metin bulunan bir blog yazısıyla çıkıyorsanız, orada bir hata yapıyorsunuz demektir.

Zira kullanıcının buradaki asıl niyeti, kalori hesaplaması yapabileceği bir hesaplama aracına ulaşmaktır. Dolayısıyla içerik sayfanızda bir hesaplama aracının bulunması öne geçmenizi sağlayacaktır. Özellikle de ''bounce rate'' oranlarınız yüksekse, search intent'e uygun içerikler üretip üretmediğinizi sorgulamanızda fayda var. Çünkü kullanıcı sizin sayfanıza tıklasa bile aradığını bulamadığı için hemen sitenizden çıkacaktır.

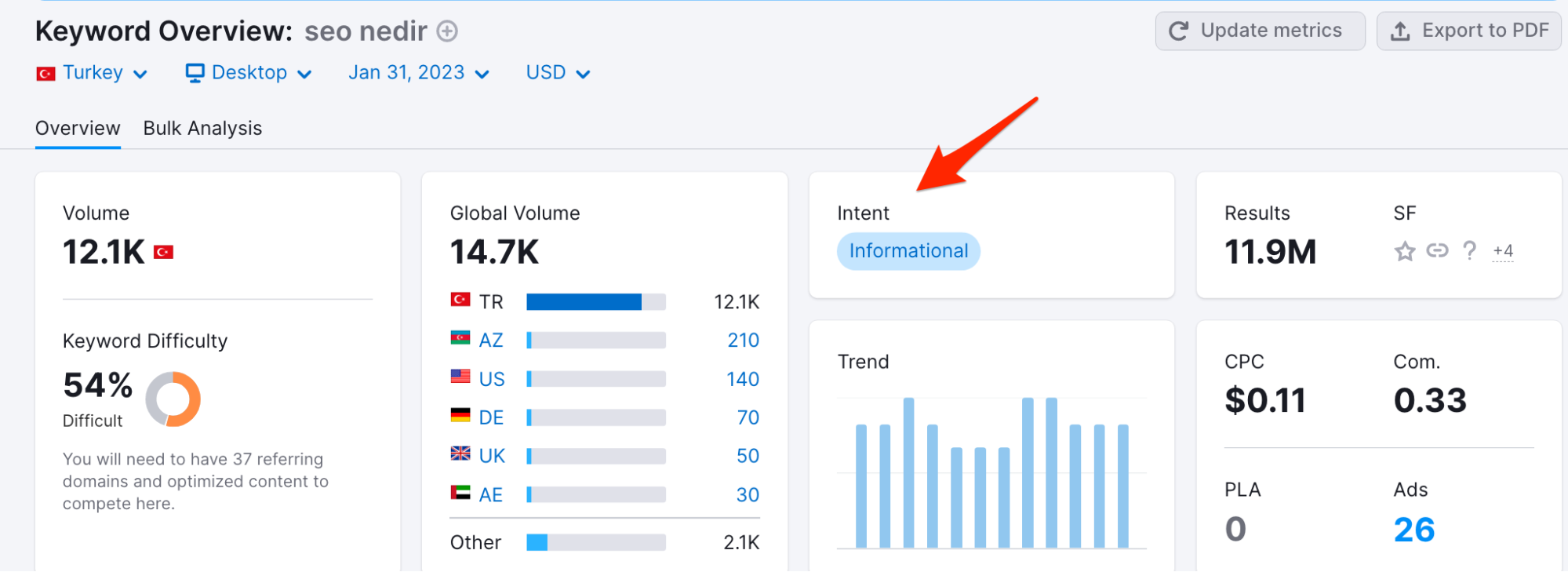

Eğer herhangi bir anahtar kelimenin arama niyetini öğrenmek istiyorsanız SEMrush’tan yardım alabilirsiniz. Örneğin, ‘’seo nedir’’ anahtar kelimesinin Informational bir sorgu olduğunu bu sayede kolaylıkla öğrenebilirsiniz.

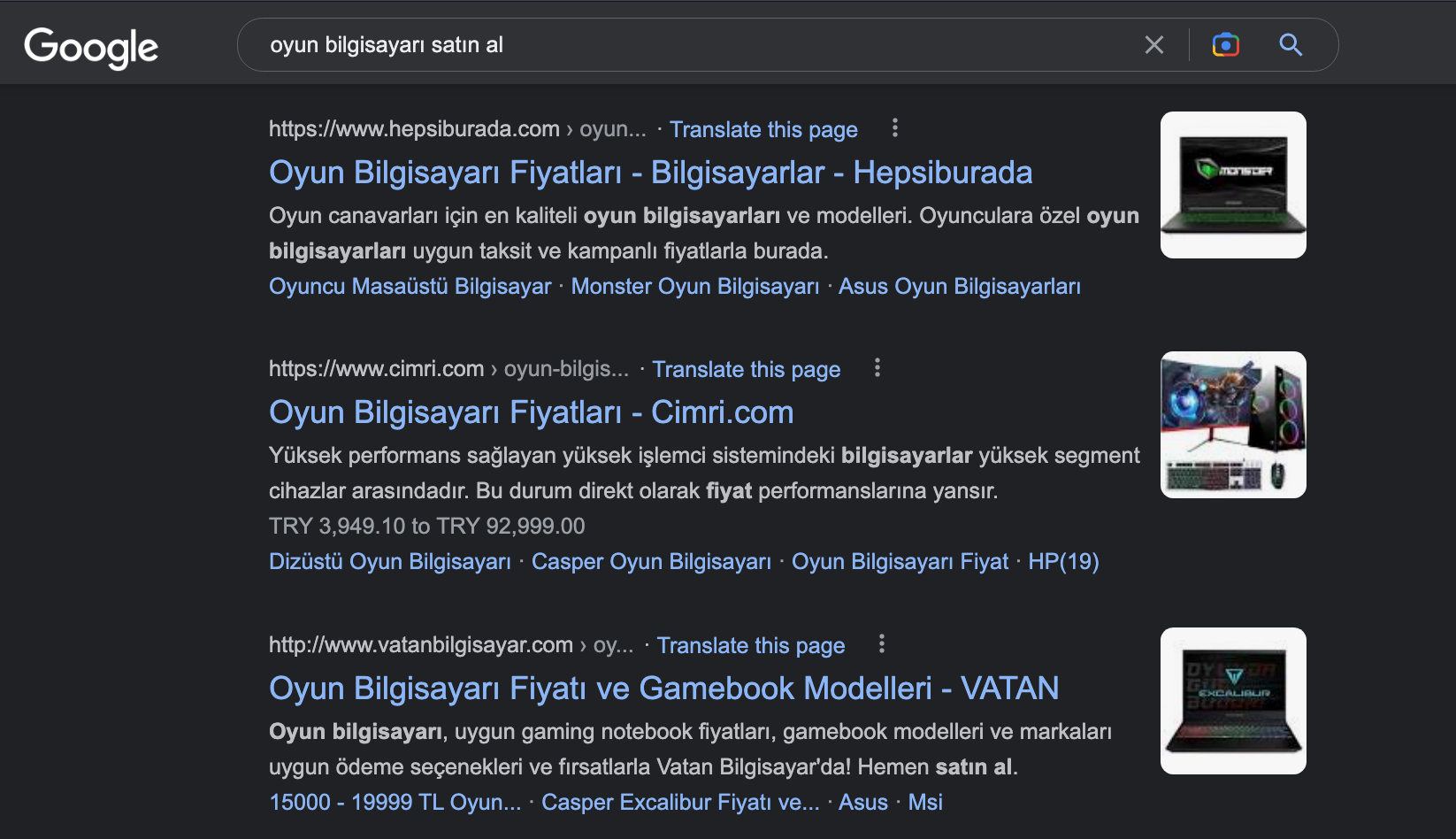

SEMrush hesabınız yoksa alternatif olarak Google manuel aramaları kullanabilir, burada karşınıza gelen sayfaların durumuna göre aksiyon alabilirsiniz. Örneğin, ‘’oyun bilgisayarı satın al’’ gibi bir arama yaptığımızda karşımıza e-ticaret sitelerinin ürün sayfaları çıkıyor.

SERP’te karşımıza çıkan bu sayfaların durumunu göz önünde bulundurarak, ‘’oyun bilgisayarı satın al’’ kelimesinin search intent’inin Transactional olduğunu söyleyebiliriz. Bu çıkarım sayesinde gerekli optimizasyonları uygulayarak ilgili sayfamızı search intent’e uygun hale getirebiliriz.

5. Heading Tag Kurgusu

İçeriklerinizde doğru bir heading kurgusu oluşturmanız, hem botlara hem de kullanıcılara içerik hiyerarşisini gösterme bakımından fayda sağlayacaktır. Örneğin, içeriklerinizde birden fazla H1 etiketi bulunuyor olabilir. Yahut H2 ve H3 gibi alt başlıklara hiç yer vermemiş olabilirsiniz. Peki, bu noktada doğru başlık kurgusu nasıl olmalı? Dilerseniz, bir sağlık içeriği ile örneklendirerek konuyu daha iyi özümsemenizi sağlayalım.

Öncelikle, kalp krizi ile ilgili bir içerik yazacağınızı düşünelim. Bu konu çerçevesinde doğru başlık hiyerarşisi şu şekilde olabilir:

Unutmayınız ki heading tag kurgusunu doğru bir hiyerarşide sunmak, içeriklerin hem arama motoru botları tarafından hem de kullanıcılar tarafından daha kolay anlaşılmasını sağlayacaktır.

6. Görsel & Medya Optimizasyonu

İçeriklerinizde sadece metin kullanıyorsanız kullanıcıları yeterince cezbedemeyebilirsiniz. Özellikle randıman alamadığınız içerikleri video ve görsellerle daha da zengin hale getirmek size oldukça fayda sağlayacaktır.

7. Genel Optimizasyon

Bu aşama, aslında içeriğinizi bir kullanıcı gözüyle okuma ve bu doğrultuda optimize etme sürecidir. Ne yazık ki SEO uyumlu içeriğin sadece arama motoru botları için içerik yazmak olduğunu düşünen ve bu doğrultuda içerik üreten pek çok kişi var. İşte rakiplerinizden farklılaşmak ve öne çıkmak için büyük bir fırsat! Siz de şu adımları takip ederek içeriklerinizi genel bir kontrolden geçirebilirsiniz:

- İçeriklerinizi her zaman kullanıcıları düşünerek üretin.

- Hedef kitlenize uygun bir iletişim tonunda içerikler üretin.

- Kısa ve net cümleler kurmaya özen gösterin.

- İçeriklerinizde tutarlı bir zaman akışı oluşturun. Bir cümle geçmiş zaman, diğer cümle geniş zaman, diğer cümle gelecek zaman, öbür cümle şimdiki zaman gibi bir yapı olmamalı.

- Giriş cümlelerini daima ilgi çekici tutun. Eğer giriş paragrafı yeterince ilgi çekici değilse kullanıcılar sitenizden bounce edebilir.

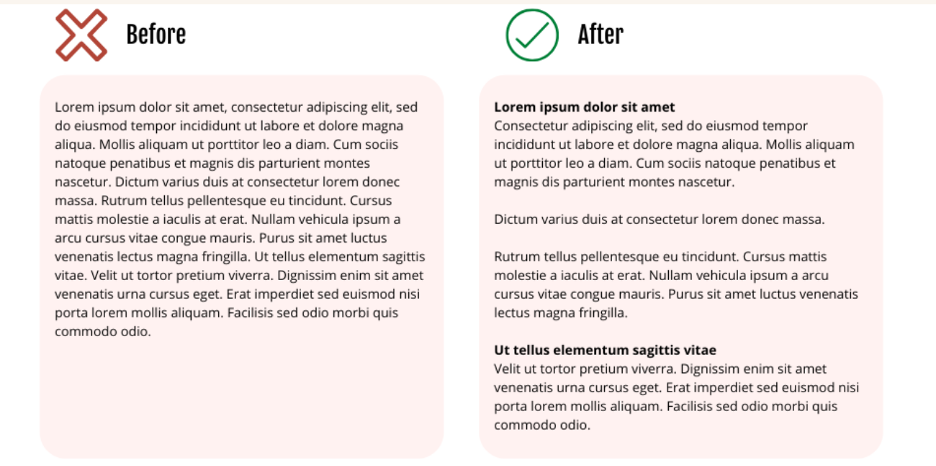

- Paragrafları göz korkutucu olmayacak şekilde bölün. Bunun önemini anlatacak bir SS paylaşmak istiyorum:

Sadece bu maddenin bile ne kadar fark ettireceğini eminim tahmin etmişsinizdir.

Sadece bu maddenin bile ne kadar fark ettireceğini eminim tahmin etmişsinizdir.

8. İç Linkleme

İçeriklerinizde iç linkleme yapmanın birçok faydası var. İç linklemeler ile sitenize gelen kullanıcıları benzer içeriklerinize yönlendirebilir, aynı zamanda botlara bu sayfaların birbiriyle alakalı olduğunu anlatabiliriz. Eğer içeriklerinizde iç linkleme kullanmıyorsanız mutlaka kullanmanızda fayda var.

9. E-E-A-T Güncellemesi

Bildiğiniz gibi Google, E-E-A-T Güncellemesini yayınladı. Artık içerikleri uzman bir kişinin üretmesi çok daha önemli hale geldi. Eğer içeriklerinizden yeterli verimi alamamışsanız, üretilen içeriklerin gerçekten bir uzman tarafından üretilip üretilmediğini kontrol edin. Yeni ürettiğiniz içeriklerin de daima bu kapsamda üretildiğinden emin olun. İçeriklerinizde yazar biyografisi kullanmayı ve yazar sayfalarını olabildiğince geliştirmeyi unutmayın.

Bu arada E-E-A-T Güncellemesi hakkında daha fazla bilgi sahibi olmak için ekip arkadaşlarımızdan Samet Özsüleyman'ın hazırladığı kapsamlı içeriğe göz atabilirsiniz.

10. Rakip Analizi

Rakip analizinin ne kadar önemli olduğunu tekrar tekrar söylemeye gerek yok. Zaten rakibimiz bizi geçtiyse, demek ki bir şeyleri bizden daha iyi yapmış demektir. Bu noktada yapmanız gereken, rakiplerin neyi daha iyi yaptığını tespit etmek ve buna göre içeriğinizi optimize ederek rakiplerinizi geçmektir. Örneğin, sizin içeriğiniz sıralama kaybederken rakibinizin içeriği yükseliş gösteriyorsa, rakibin ürettiği içeriği ve aldığı backlinkleri iyice gözlemlemenizi tavsiye ederiz. Bu yazdığımız maddeleri de bir checklist gibi düşünüp rakibinizin içeriğiyle kendi içeriğinizi bu bağlamda karşılaştırabilir, aradaki farkı çok daha rahat görebilirsiniz.

Duplicate Content (Çift/Tekrarlı İçerik)

Duplicate Content, sitemizdeki bir içeriğin benzerinin ya da aynısının yine kendi sitemizde bulunması ya da başka bir sitede olmasıdır. Peki, bir karar vermek zorunda olsaydınız sitenizdeki benzer içerikleri Google’da nasıl sıralardınız? Evet, karar vermesi zor. Arama motoru botları için de öyle.

Arama motoru botları benzer/aynı içeriğe sahip sayfaları gördüğünde hangisini önce sıralayacağına karar veremeyebilir ve benzer içeriğe sahip tüm sayfalar düşük pozisyonda sıralanabilir. Hatta kopya içerik barındıran sayfaların sıralamasını bazen düşürerek kaliteli ve özgün içeriğe sahip sayfaları sıralayabilir. Yani sitemizde yinelenen içerikler bulunduğunda sayfalarımız etkin bir şekilde listelenmeyebilir. Listelense bile yinelenen içerik, orijinal sayfa ile yarışacağından sayfaların performansları istediğimiz şekilde olmayabilir.

Bir web sitesinde aynı içeriklerin farklı sayfalar ile sunulması arama motoru botlarına karışık sinyaller göndereceği gibi tarama bütçesini de olumsuz yönde etkileyecektir. Taranmasını tercih etmediğimiz sayfaların taranması, güncel olarak eklenen ve önemli gördüğümüz sayfalarımızın taranmaması istemediğimiz bir durumdur. Tarama bütçesini verimli kullanmak adına yinelenen içerikleri SEO projelerinin başlangıcında olduğu gibi tüm süreçte düzenli olarak kontrol etmekte fayda görüyoruz.

Duplicate content problemine manuel kontroller ile rastlayabileceğimiz gibi, Screaming Frog ve Lumar (eski adıyla Deepcrawl) gibi araçlar ile teknik tarama yapıldığında da karşılaşabiliriz.

Kopya içerikler birçok farklı şekilde karşımıza çıkabilir. Bu yüzden SEO projesine ilk başladığımızda kontrol etmemiz gereken noktalara değineceğim.

Farklı Domain Sürümleri

Aynı içeriği farklı protokollerde bulundurduğumuzda, arama motoru botları bu sayfaları farklı görmektedir. İki farklı sayfanın aynı içeriğe sahip olduğunu düşündüğümüzde yinelenen içerik sorunu ile karşılaşıyoruz. Bir web sitesinin HTTP ve HTTPS versiyonları ile WWW olan ve WWW olmayan farklı mevcut sürümleri olabilir. Aynı içeriklere hem www.example.com hem de example.com adresinden ulaşılabiliyorsa veya http://www.example.com ve https://www.example.com adreslerinden ulaşılabiliyorsa yinelenen içerik sorunu ile karşılaşabilirsiniz demektir.

Sitemizin WWW olan ve WWW olmayan versiyonları olduğunu düşünelim. WWW olan versiyona gelen harici linkler ve WWW olmayan versiyona gelen harici linklerimiz olacaktır. Bu durumda SEO performansımızın bölüneceğini, sayfaların birbiri ile yarışarak otoritelerinin olumsuz etkileneceğini söyleyebiliriz.

WWW sorunu için çözüm, tercih edilen sürüme 301 kalıcı yönlendirmesi yapılmasıdır. HTTP sorunu için ise tercih edilen çözüm, ilgili sayfaların HTTPS versiyonuna 301 ile yönlendirilmesidir.

URL’de Eğik Çizgi (Slash) Kullanımı

Eğik çizgi içeren ve içermeyen sayfalar kopya olarak görülebilir. İlgili sayfalara URL’in sonunda / olacak şekilde ve aynı şekilde / olmadan ulaşılıyorsa yinelenen içerik sorunumuz var demektir. Bu durumda eğer hangi seçenek bizim orijinal sayfalarımız ise, o sayfalarımıza 301 kalıcı yönlendirmesi yapmalıyız.

URL Varyasyonları: Parametreli URL’ler

Site içi filtrelemeler, sayfalandırmalar, sıralamalar veya oturum kimlikleri için kullanılan parametreler yinelenen içerik sorununa neden olabilmektedir.

Örneğin; e-ticaret sitelerinde rastlayabileceğimiz parametreli bir URL aşağıdaki gibi olabilir:

www.example.com/?q=women-shoes?color=red

Parametreli URL’lerimizin çift içerik sorunu yaratmaması için canonical etiketlerini kullanarak, arama motoru botlarına listelenmesini istediğimiz standart URL’imizi bildirebiliriz.

Duplicate içerikler için bir ceza alınmasa da, organik trafiği artırmak ve otoriteyi güçlendirmek için mutlaka özgün sayfa yapılarımız olmalıdır.

Keyword Cannibalization

Projeye ilk başladığımızda özellikle bizler için en önemli anahtar kelimeler ile hedeflediğimiz sayfaların performanslarını inceleriz. Bazen durum pek parlak olmayabilir. Bunun bir nedeni aynı anahtar kelimede farklı sayfalar ile SERP’te listelenmeye çalışmamız olabilir.

Sayfa performanslarını düşüren nedenlerden biri de keyword cannibalization yani anahtar kelime yamyamlığıdır. SEO tarafında en yaygın yanılgılardan biri bir anahtar kelime ile farklı sayfalarda sıralanılırsa daha çok trafik alınacağının düşünülmesidir. O nedenle birçok kişi aynı anahtar kelimeyi hedefleyerek aynı konuda birden fazla içerik oluşturarak iyi bir pozisyonda listelenmeyi bekliyor. Ancak durum bunun tam tersi diyebiliriz. Aynı anahtar kelimeler ile farklı sayfaları hedeflediğimizde aslında sayfaları kendi içlerinde yarıştırıyoruz.

Dolayısıyla birbirlerinin SEO performanslarını düşürmüş oluyoruz. Aynı veya çok benzer anahtar kelime ile ilgili sorgularda bir A sayfanızın listelendiğini bir de B sayfanızın listelendiğini görebilirsiniz. Bu caselerde kendimize rakip yine kendimizizdir.

Ancak aynı anahtar kelimede farklı sayfalarımızın sıralandığı tüm durumlar için keyword cannibalization sorunu olduğunu söylemek doğru değildir elbette. Kullanıcı niyeti, sayfaların hangi amaç ile oluşturulduğu oldukça önem taşımaktadır. Örneğin; e-ticaret sitelerinde aynı anahtar kelime ile birden çok sayfanın sıralanması oldukça muhtemel bir durum. Informational sorguda kullanıcıya bilgi veren bir sayfa ile transactional sorgular için oluşturulan satın alma sayfaları muhtemelen keyword cannibalization sorununa neden olmayacaktır.

Arama motoru botları kullanıcı niyetini anlayarak, en alakalı sonuçları SERP’te sunacaktır.

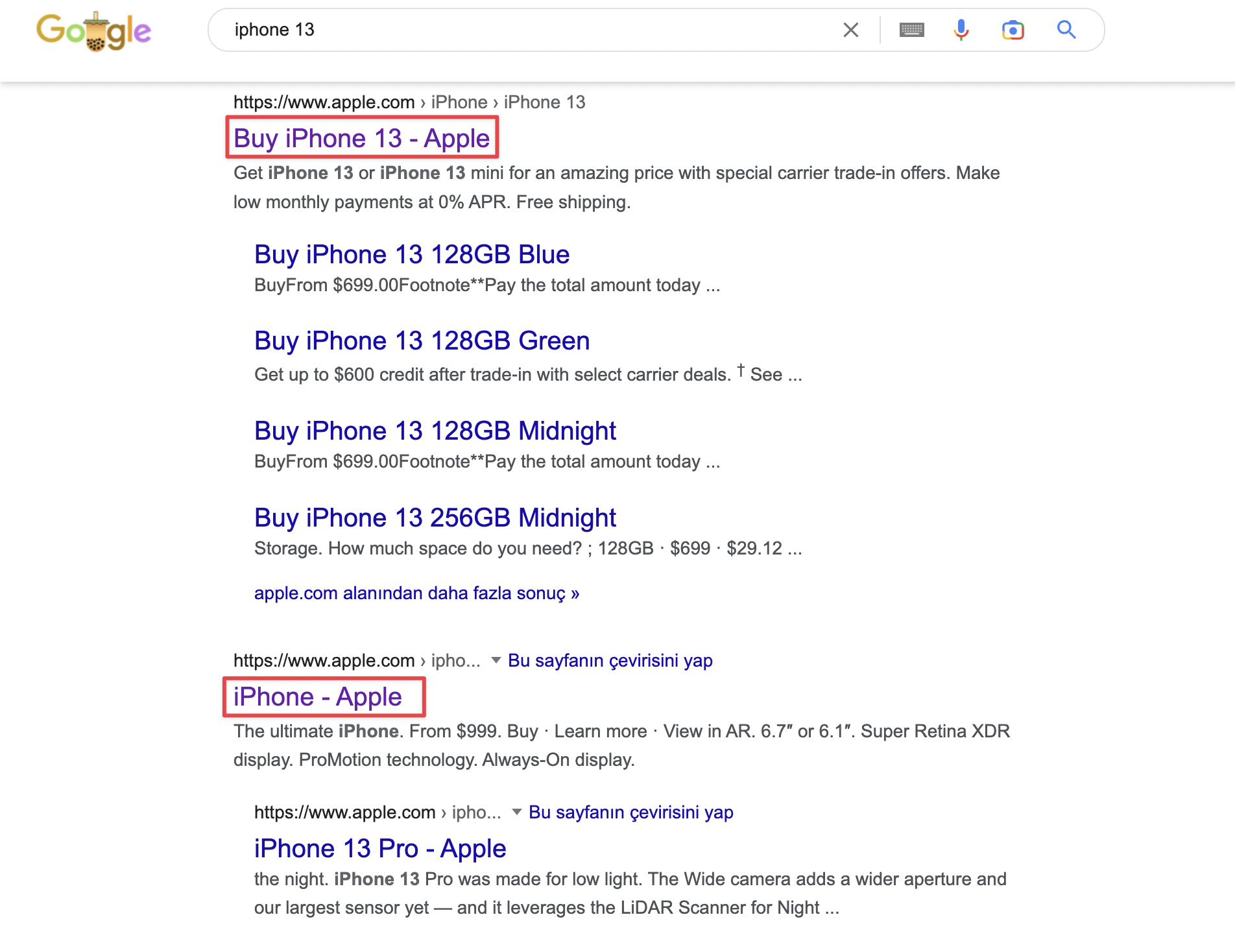

Örneğin; iphone 13 anahtar kelimesi ile arama yaptığımızda SERP’te Apple’ın 2 sayfası ile karşılaşıyoruz. Biri iphone 13 satın alma sayfası biri ise tüm iphone modelleri ile ilgili bilgilerin yer aldığı sayfa.

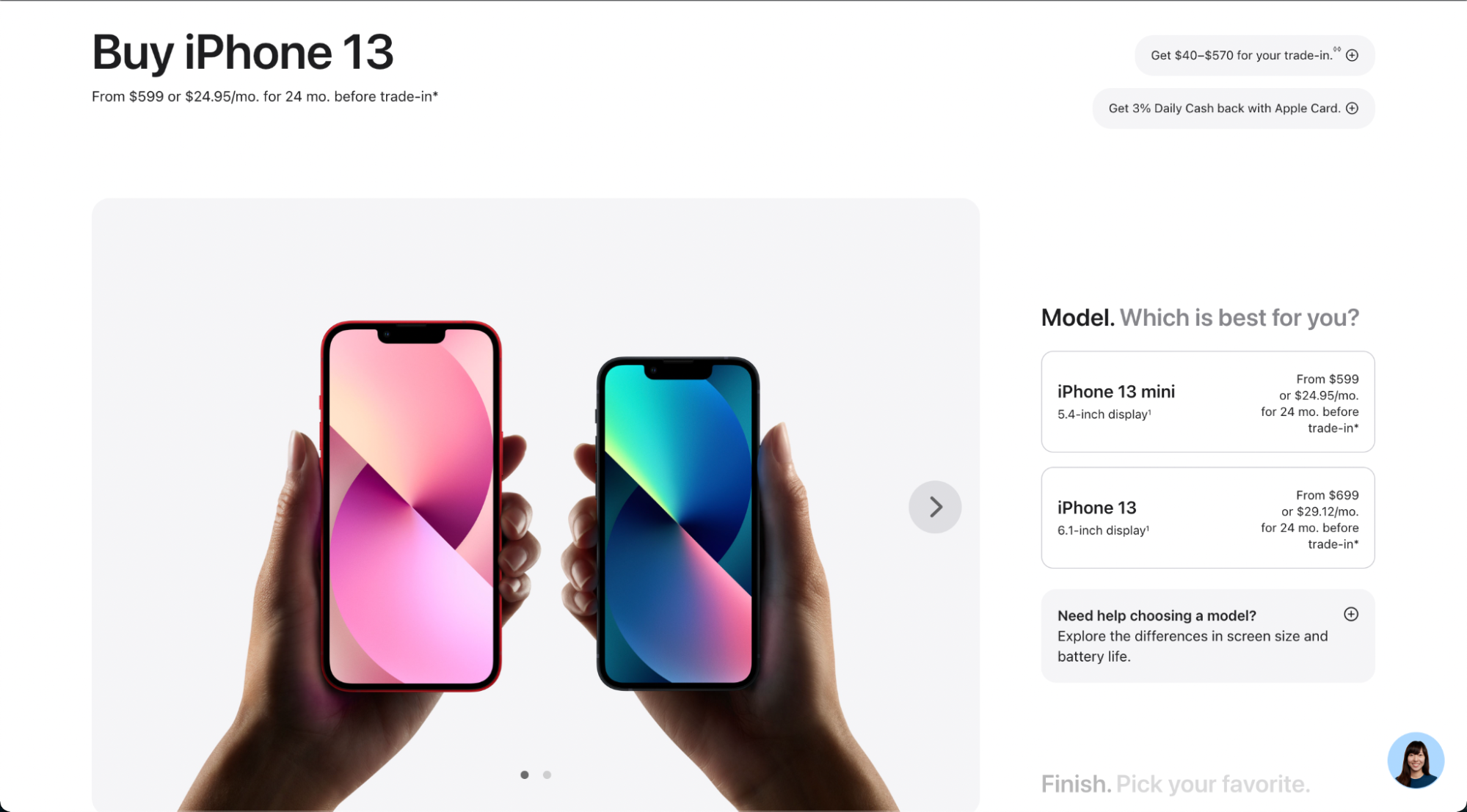

“iphone 13” kelimesi ile ilk sırada listelenen “Iphone 13 satın al” sayfası:

“iphone 13” kelimesi ile 2. sırada listelenen “Iphone” sayfası:

Bu sayfalar aynı anahtar kelimede listelense de farklı kullanıcı niyetine göre oluşturulduğunu görüyoruz. O nedenle cannibalization sorununa neden olmayabilir.

Keyword cannibalization kontrolü neden önemlidir?

- Sayfa otoritelerini bölmemek, değerlerini kaybetmemek için önemlidir.

- İlgili sorguyla en alakalı sayfanın iyi bir pozisyonda sıralanması ve iyi bir organik trafik alması için önemlidir.

- Tarama bütçesini verimli kullanmak için önemlidir.

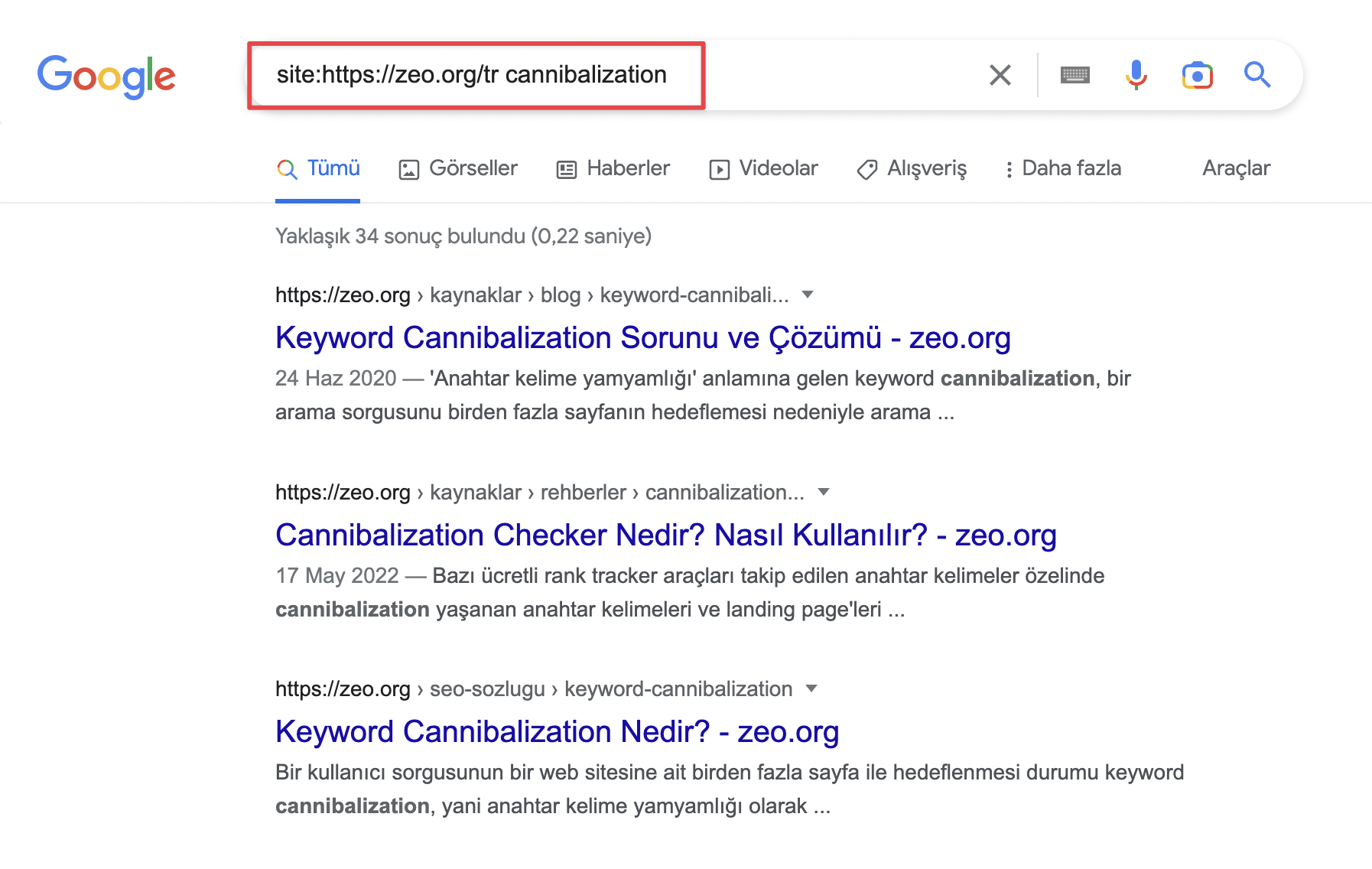

Keyword cannibalization kontrolünde en hızlı ve pratik yöntem, “site:example.com anahtar kelime” araması yaparak ilgili sorguda sıralanan tüm sayfalarınızı incelemektir.

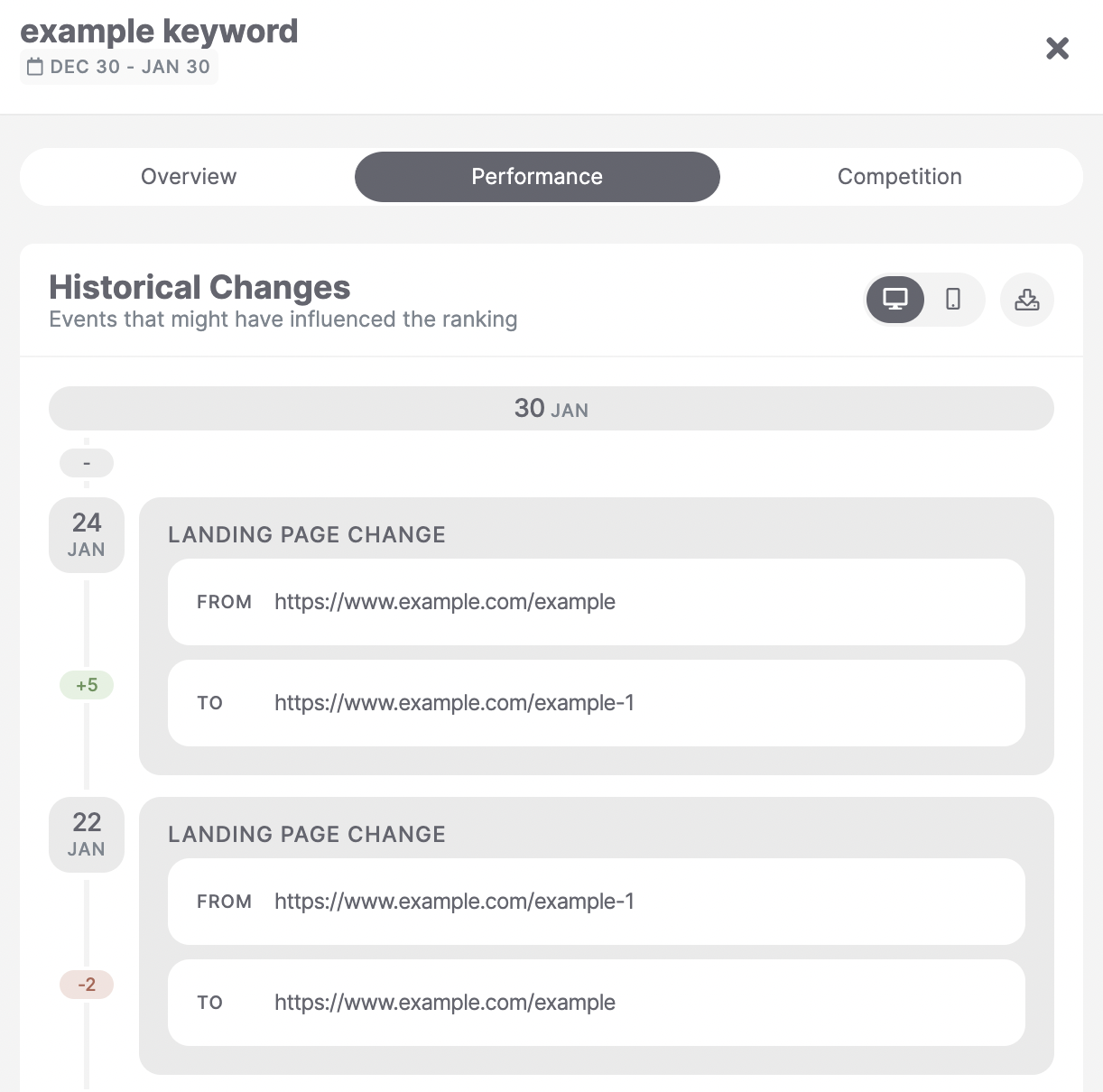

Manuel kontrolün yanında, her projede belirlediğimiz anahtar kelimeleri takip ettiğimiz bir aracımız bulunuyor. Anahtar kelimelerimizin performansını takip ettiğimiz en yaygın araçlardan biri de SEOmonitor. SEOmonitor, günlük olarak anahtar kelimeleri kontrol ederek keyword cannibalization sorunu olan kelimeleri tespit eder ve aşağıdaki gibi uyarı verir.

SEOmonitor ile ilgili anahtar kelimelerin hangi sayfalar ile sıralandığını ve zamanla değişimlerini “Performance” alanından inceleyebilirsiniz. Sayfaları ayrıca manuel incelemek oldukça faydalı olacaktır. Manuel inceleme sonrasında birbirleri ile yarışan sayfalar için en uygun çözüme karar verebilirsiniz.

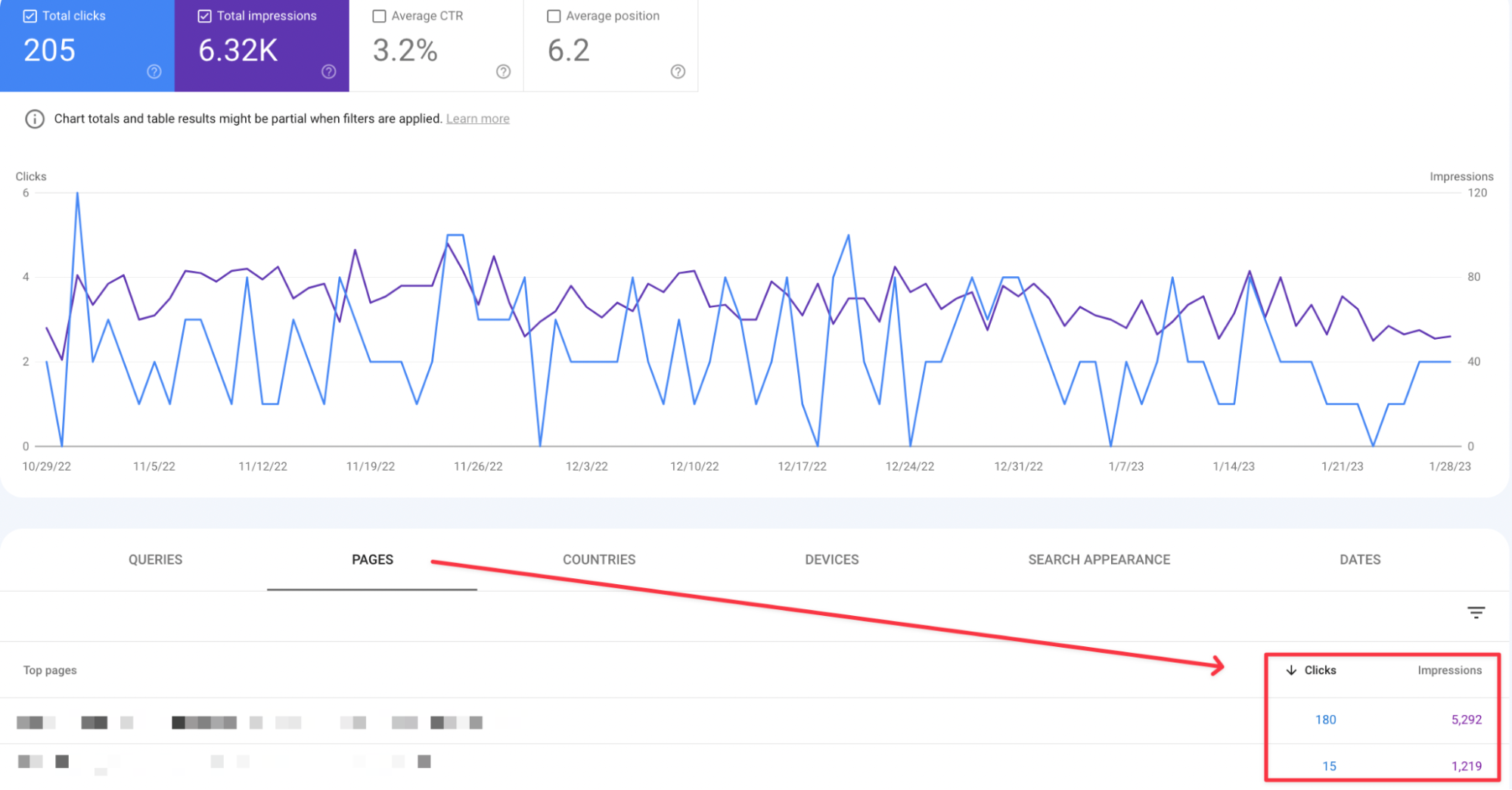

Bunun yanında projeye yeni başladığımızı, henüz anahtar kelime performansı takibi için araçları kurmadığımızı düşünürsek sıklıkla kullandığımız ve bizleri aydınlatacak olan araç tabii ki Search Console olacaktır. Farklı bir araç kullanarak anahtar kelime takibi yapsak bile Search Console ile birçok kontrolümüzü ücretsiz bir şekilde gerçekleştirebiliriz.

Herhangi bir anahtar kelimede hangi sayfaların sıralandığını kontrol etmek için Search Console hesabınızda “Query” kısmına dilediğiniz sorguyu yazabilir ve “Pages” alanında ilgili sorguda trafik alan sayfalarınızı inceleyebilirsiniz. Veya direkt olarak belirli sayfa performanslarını merak ediyorsanız sayfa karşılaştırmaları ile araştırmanızı yapabilirsiniz.

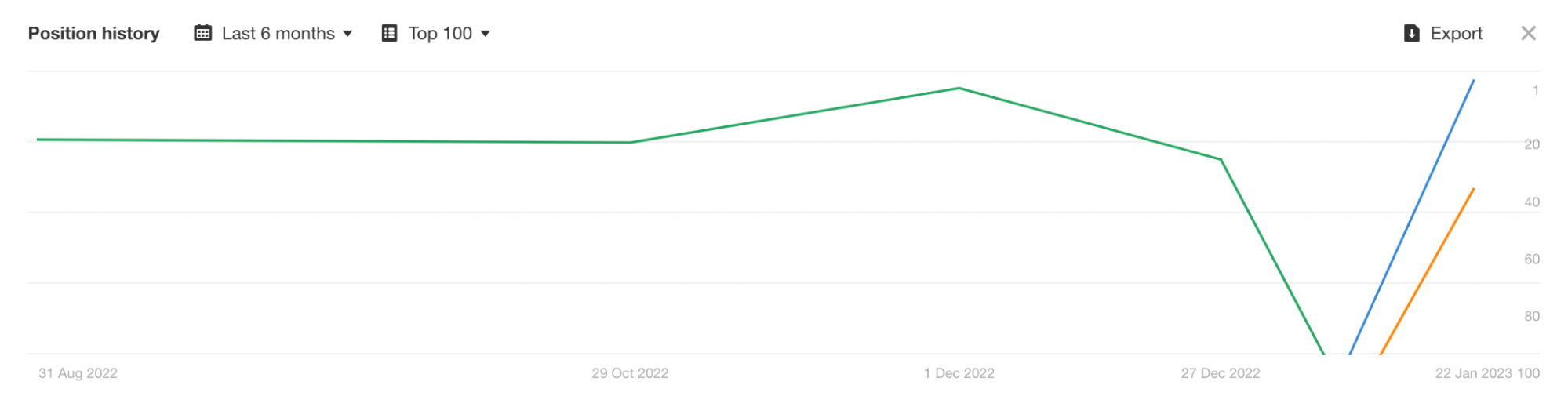

Dilediğiniz süre aralığında, belirli bir anahtar kelimede sıralanan sayfalarınıza Ahrefs “Position history” alanından ulaşabilirsiniz. Aşağıdaki örnekte bir anahtar kelime için üç farklı sayfanın sıralandığını görüyoruz.

Birçok yöntem ile veri toplayabilirsiniz. Ekibimizden Can’ın Cannibalization Checker Nedir? Nasıl Kullanılır? blog yazısı ile ZEO’nun ücretsiz olarak sunduğu Cannibalization Checker’ın nasıl kullanıldığı hakkında bilgi sahibi olabilir ve çalışmalarınızda kullanabilirsiniz.

Keyword Cannibalization Çözüm Yöntemi

Internal Link Yapısını Düzenleme

Cannibalization sorununun çözümlerinden biri doğru bir site içi linkleme kurgusu oluşturmaktır. Doğru anahtar kelimeler ile doğru sayfaları hedefleyerek bir kurgu oluşturulduğunda, ilgili anchor textler ile arama motoru botları ve kullanıcılara sayfalar hakkında bilgi verilerek yönlendirilebilir.

Title & Meta Description Düzenlemeleri

Aynı anahtar kelimede listelenmek için yarışan, rakip sayfalarımız varsa sayfaların title ve meta description etiketlerindeki düzenlemeler ile cannibalization sorununun çözülmesi denenebilir. Sayfaların farklı hedefleri olacak şekilde düzenlemeler yapılmalıdır.

301 ile Kalıcı Yönlendirme

Cannibalization sorununa sahip duplicate içeriklere sahip sayfalar ise direkt performansı iyi olan sayfaya 301 kalıcı yönlendirmesi ile çözüm yoluna gidilebilir.

Noindex Kullanımı

Bazen belirli nedenlerle soruna neden olan sayfalar silinemeyebilir veya yeniden yönlendirilemeyebilir. Organik trafiği olmayan, zayıf içerikli sayılabilecek sayfalarımız keyword cannibalization sorununa neden olabilir. Bu gibi durumlarda indekslenmesi istenmeyen sayfanın meta noindex etiketi kullanılarak indekslenmemesi tercih edilebilir.

Noindex etiketi uyguladığımız sayfada dikkat edeceğimiz nokta ise rel=canonical kullanımıdır. Google’dan John Mueller yaptığı açıklamada canonical ve noindex etiketinin birlikte kullanımı sonucunda Google’a çelişkili sinyaller gönderildiğini belirtmişti. Bu bilgiye göre noindex etiketi ekleyeceğimiz sayfalarda rel=canonical etiketi varsa kaldırmak önceliklerimizden olacaktır.

Rakip Analizi

Rakip analizi SEO stratejisinin belirlenmesinde büyük rol oynuyor. Bir SEO projesine başlarken sitenin genel kontrolü dışında rakip analizi ile beraber potansiyeli ve eksiklikleri görmek, stratejiyi oluştururken fayda sağlayacaktır. Rakiplerin hangi kelimelerde listelendiğini, ne tip içeriklere odaklandığını, güçlü ve zayıf yönlerini belirlemek alınacak aksiyonların belirlenmesini kolaylaştıracaktır. İlk etapta gerçekleştirilecek bu analizin, SEO çalışmaları süresince devam eden bir süreç olduğunun da altını çizmemiz gerekiyor.

Rakip analizi sayesinde;

- Hedeflenecek kelimelerin belirlenmesi,

- Ne tip içeriklerin üretileceğinin belirlenmesi,

- Bu içeriklerin nasıl optimize edileceği,

- Bu içeriklere ne tip sitelerden link edinebileceği konularında fikir sahibi oluyoruz.

Gelin adım adım bu analizi nasıl gerçekleştireceğimize bakalım.

Rakiplerin Belirlenmesi

Offline tarafta rakip olarak gördüğünüz markalar ya da siteler SEO tarafında en güçlü rakipleriniz olmayabilir ya da sitenizin farklı alanları için farklı rakipleri ele almanız gerekebilir.

Ahrefs, Semrush gibi araçlar bu konuda size yardımcı olacaktır. Rakip analizi kapsamında ele aldığımız tüm maddeleri bu tip araçlar üzerinden gerçekleştirebilirsiniz. Sitenizle listelendiğiniz kelimelerde organik tarafta kimlerle yarıştığınızı görebilir ve bu rakipleri inceleyebilirsiniz. Ayrıca gerçekleştireceğiniz anahtar kelime analizi sonrasında yaptığınız gruplandırmalar özelinde farklı organik rakipleri de belirleyerek stratejinize yön verebilirsiniz.

Rakipleri belirlerken sadece yüksek hacimli kelimelere odaklanmak potansiyel yüzlerce sorguyu kaçırmanıza neden olabilir. Düşük hacimli ancak direkt satın alma ya da form doldurma gibi aksiyona yönelik sorguları da incelemek sitenizde istediğiniz dönüşüm oranına katkı sağlayacaktır.

Rakipleri belirlerken hangi siteler ile rekabet etmeyeceğinizi de belirlemek önemlidir. Örneğin Wikipedia gibi kaynakları geride bırakmaya efor sarf etmek doğru bir strateji olmayabilir.

Rakiplerin Listelendiği Sitemizin Listelenmediği Anahtar Kelimelerin Tespiti (Keyword Gap Analizi)

Rakiplerinizin listelendiği ancak sizin listelenmediğiniz anahtar kelimelerin tespiti için “Keyword Gap” terimini kullanıyoruz. Keyword Gap analizi sayesinde rakiplerlinizle aranızdaki farkı kapatabilir, stratejinize yeni fikirler ekleyebilirsiniz. Bu kelimeleri tespit ederken aşağıdaki sorulara yanıt verecek şekilde analizler gerçekleştirmek gerekiyor:

- İlgili kelimelerde neden listelenmiyorum? Bu kelimelerle ilgili ürün ya da hizmet sunuyor muyum?

- İlgili kelimelerde rakiplerim ne tip içeriklerle listeleniyor? Hizmet ya da ürün sayfasıyla mı yoksa bilgilendirici bir blog içeriğiyle mi listeleniyor?

- İlgili kelimelerde listelenen sayfalar için off-site SEO teknikleri kullanılmış mı? Link building çalışması yapılmış mı?

Detaylandırabilmek adına bir örnek üzerinden ilerleyelim. Psikolojik danışmanlık veren bir websitemiz olduğunu varsayalım. “Anksiyete Nedir? Kaygının Sebepleri, Belirtileri ve Türleri” konulu bir blog içeriği hazırlayarak kullanıcıların bilgilendirici içeriğimize gelmesini sağlayabilir ve içerikten kullanıcıları danışmanlık hizmetimize yönlendirebiliriz.

İyi Perfomans Gösteren Sayfaların Belirlenmesi

Rakiplerinize en çok trafiği getiren sayfaların belirlenmesi rakip analizinin bir parçası olmalıdır. Genel tabloya baktığınızda yüksek trafik elde eden bir rakibiniz olduğunu varsayalım. Trafik elde eden sayfalarına baktığınızda bu rakip trafiğinin %90’ını ana sayfasından ve marka sorgularından alıyor. Bu durumda bu rakibin SEO stratejisini incelemek çok mantıklı olmayabilir. Diğer tarafta ise içerik üreten, ürün ya da hizmet sayfalarına trafik çeken bir rakip olsun. Bu rakibin trafik çeken sayfalarını incelemek ve fikirler almak doğru strateji olacaktır.

Bu analizi gerçekleştirirken incelenmesi gereken bir diğer önemli detay içerik tiplerini belirlemek olacaktır. Örneğin bir e-ticaret sitesi “how-to” rehberleriyle trafik çekiyor olabilir ya da niş bir sektördeki rakibiniz detaylı içerik rehberleri üretiyor ve trafiği bu şekilde alıyor olabilir.

Backlink Profilinin İncelenmesi

Otorite sahibi websitelerinden sitelere verilen linklerin sıralamalara olan etkisi günümüzde hala devam ediyor. Rakiplerinizin backlink profillerini inceleyerek bu tarafa kaynak ve zaman ayırıp ayırmadıklarını belirlemenize yardımcı olacaktır. Bu çalışmayı yaparken sayfa bazlı inceleme yapmak önemlidir. Ahrefs ve Semrush gibi araçlar yine bu konuda size yardımcı olacaktır.

Rakiplerinize link veren siteleri inceleyerek ilgili içeriğinize ya da hizmetinize yer vermeleri için iletişime geçmeyi stratejinize ekleyebilirsiniz. Bir diğer ipucu ise iki ya da daha fazla rakibinize link veren bir içeriğin size de link verme olasılığının yüksek olmasıdır. Araçlar üzerinden bu tip içerikleri belirleyerek outreach çalışması gerçekleştirebilirsiniz.

Kapanış

Belirttiğimiz kontroller ve aksiyon önerileriyle beraber SEO projesinin en başında öncelikli ve etkisi yüksek işleri planlayarak yüksek organik trafik elde etmeniz temennisiyle yazımızı sonlandıralım. :)

Yardımcı olabilecek kaynaklar: