AI Crawler'lar ve SEO: Web Siteler İçin Optimizasyon Stratejileri

Yapay zeka (AI) teknolojilerinin hızla yaygınlaşmasıyla birlikte, web sitelerinin SEO stratejilerini de bu değişime uyum sağlayacak şekilde geliştirmesi gerekmektedir. Geleneksel arama motorlarının yanı sıra, OpenAI'nin GPTBot'u ve Anthropic'in ClaudeBot'u gibi AI crawler'larının web trafiğindeki artan payı, web sitelerinin bu yeni nesil tarayıcılar için özel olarak optimize edilmesi gerekliliğini ortaya koymaktadır.

Şimdi gelin, yapay zeka crawler'larının teknik özelliklerini ve web siteleri için en etkili optimizasyon stratejilerini ayrıntılı bir şekilde inceleyelim.

AI Crawler'ların Teknik Özellikleri

Trafik Hacmi ve Dağılım

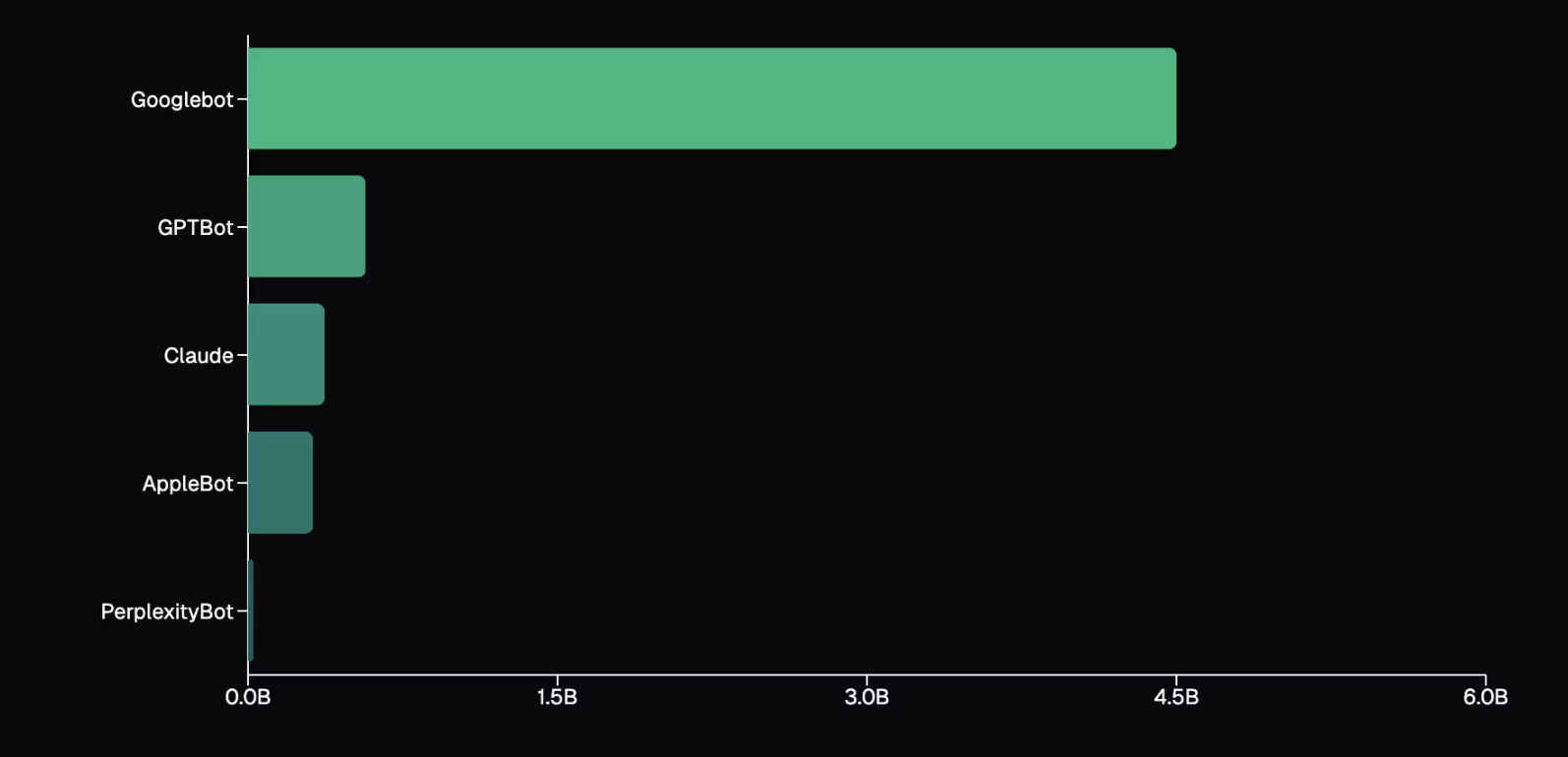

Son dönemde AI crawler'larının web üzerindeki etkisi giderek artmaktadır. OpenAI'nin GPTBot'u aylık 569 milyon istekle dikkat çekerken, Anthropic'in ClaudeBot'u da 370 milyon isteğe ulaşmıştır. Bu iki AI crawler toplamda 939 milyon isteği temsil ederek web trafiğinde önemli bir paya sahip olduklarını göstermektedir.

Bunların yanı sıra PerplexityBot da 24.4 milyon istekle bu alanda yerini almıştır. Bu rakamlar AI tabanlı tarayıcıların geleneksel arama motorlarına kıyasla ne denli büyük bir trafik hacmi oluşturduğunu ortaya koymaktadır. Örneğin, Googlebot'un aylık 4.5 milyar isteği olduğu düşünüldüğünde; AI crawler'larının toplam isteklerinin Googlebot'un yaklaşık %28'ine denk geldiği anlaşılmaktadır.

Altyapı ve Erişim Özellikleri

AI crawler'lar, web sitelerini tarama ve içerik toplama konusunda geleneksel arama motorlarından ayrılan belirli altyapı ve erişim özelliklerine sahiptir. Bu botlar özellikle JavaScript işleme konusunda sınırlı kalmaktadır. OpenAI'nin GPTBot'u ve Anthropic'in ClaudeBot'u JavaScript dosyalarını alabilse de bu dosyaları çalıştırma yetenekleri bulunmamaktadır. Bu nedenle, önemli içeriklerin sunucu tarafında oluşturulması (server-side rendering - SSR), bu botların içeriği daha iyi anlamasını sağlar.

Gemini, diğer AI crawler’larından farklı olarak Google'ın altyapısını kullanarak web tarama işlemlerini gerçekleştirmektedir. Bu durum, Gemini'nin JavaScript'i tam olarak işleyebilmesine olanak tanır. Googlebot'un altyapısından yararlanarak modern web uygulamalarını daha etkili bir şekilde tarama ve içeriklerini anlama konusunda Gemini'ye önemli bir avantaj sunmaktadır. Böylece Gemini, web sitelerinin dinamik içeriklerini daha iyi değerlendirebilmektedir.

AppleBot ise tarayıcı tabanlı bir crawler sistemi kullanmaktadır. Bu sistem JavaScript ve diğer kaynakları işleyerek tam sayfa render'ı yapabilme yeteneğine sahiptir. AppleBot'un bu yaklaşımı, web sitelerinin içeriklerini daha kapsamlı bir şekilde taramasına olanak tanırken, AI crawler'larının içerik önceliklendirme yaklaşımlarını da etkileyen bir faktördür.

İçerik İşleme Özellikleri

AI crawler'lar, web sitelerindeki içerikleri analiz etme ve işleme konusunda belirgin özelliklere sahiptir. Bu botlar, içerik türlerine göre farklı önceliklendirme yaklaşımları benimser.

OpenAI'nin ChatGPT'si HTML içeriklerine büyük bir ağırlık vererek toplam fetch taleplerinin %57,70'ini bu tür içeriklerden oluşturmaktadır. Bu durum, AI crawler'ların metin tabanlı içeriklere olan ilgisini ve bu içeriklerin SEO açısından ne kadar önemli olduğunu ortaya koymaktadır.

Görsel içerik ise AI crawler'lar için önemli bir diğer kategori olarak öne çıkmaktadır. ClaudeBot gibi botlar, toplam fetch taleplerinin %35,17'sini görsel içeriklere ayırmaktadır. Bu görsellerin, web sitelerinin genel SEO performansında kritik bir rol oynadığını ve AI araçlarının görsel verileri analiz etme yeteneğinin arttığını göstermektedir.

AI crawler'larının JavaScript dosyalarını indirme ancak çalıştırmama özelliği, içerik işleme sürecinde önemli bir sınırlama oluşturmaktadır. Bu nedenle web geliştiricilerin önemli içeriklerini sunucu taraflı renderlama ile (server-side rendering - SSR) sunmaları, AI crawler'larının bu bilgileri daha iyi anlamasını sağlaması açısından çok önemlidir.

Okumaktan yoruldunuz mu?

Bu blog yazısının, Google NotebookLM ile oluşturulmuş sesli özetini Spotify'dan da dinleyebilirsiniz.

AI Crawler’ları için Optimizasyon Önerileri

Server Side Rendering Stratejileri

Web sitelerinin performansını artırmak ve AI crawler'ları için daha erişilebilir hale getirmek için sunucu taraflı renderlama (SSR) stratejileri kritik öneme sahiptir. Dinamik içeriklerin bu yöntemle sunulması hem kullanıcı deneyimini iyileştirir hem de arama motorları tarafından daha kolay indekslenmesini sağlar. Bu nedenle, dinamik içeriklerin sunumunda SSR yönteminin tercih edilmesi, web sitelerinin görünürlüğünü artırır.

SSR'nin yanı sıra aşağıdaki yöntemlerin de kullanılması önerilir:

- Incremental Static Regeneration (ISR): Belirli sayfaların güncellenmesini sağlar.

- Static Site Generation (SSG): Statik içeriklerin hızlı bir şekilde sunulmasına olanak tanır.

Bu yöntemler, web sitelerinin performansını artırmakla kalmaz, aynı zamanda AI crawler'larının içerikleri daha etkili bir şekilde taramasını sağlar.

Meta bilgilerin ve navigasyon yapılarının optimize edilmesi de önemli bir faktördür. Meta başlıkları ve açıklamaları, arama motorları için önemli birer sinyal oluştururken, kullanıcıların da sayfalar arasında daha kolay gezinmesini sağlar. Navigasyon yapılarının düzenli ve anlaşılır olması hem kullanıcı deneyimini iyileştirir hem de AI crawler'larının web sitenizi daha etkin bir şekilde taramasına yardımcı olur.

AI crawler’larının gelecekte Javascript kaynaklarını da işleme yeteneklerinin artacağı öngörülse de günümüzde bu hızlı değişime ayak uydurabilmek adına kritik içeriklerin veya kaynakların SSR ile sunulması önemlidir.

Crawler Kontrolü ve Güvenlik

Web sitelerinin güvenliği ve içeriklerinin korunması, özellikle yapay zeka tabanlı crawler'ların artan kullanımıyla daha da önemli hale gelmiştir. Bu bağlamda, crawler kontrolü ve güvenlik stratejileri geliştirmek, web yöneticileri için öncelik olmalıdır.

Web sitenizin hangi bölümlerinin arama motorları ve AI botları tarafından taranabileceğini kontrol etmek için `robots.txt` dosyasını kullanmak önemlidir. Hassas içeriklerin bulunduğu sayfaların taranmasını engelleyerek bu bilgilerin botlar tarafından toplanmasını önleyebilirsiniz. Örneğin, şirketinizin çeyreklik finansal raporlarını yayınladığınızı düşünelim. Bu raporlar, yayınlandıktan sonra güncelliğini yitirebilir. Bu yüzden `robots.txt` dosyasını kullanarak AI botlarının bu raporları taramasını engelleyerek, eski bilgilerin toplanmasını önleyebilirsiniz. Böylece, sadece güncel ve resmi verilerin ulaşılabilir olmasını sağlayabilirsiniz.

Web uygulama güvenlik duvarları (WAF), istenmeyen AI botlarının ve diğer kötü niyetli trafiğin web sitenize erişimini kontrol etmede etkili bir araçtır. WAF kullanarak belirli crawler’ları engelleyebilir veya belirli kurallara göre trafiği filtreleyebilirsiniz. Bu, özellikle istenmeyen bot trafiği ile karşılaşan web siteleri için faydalıdır. WAF yalnızca güvenliği artırmakla kalmaz, aynı zamanda sitenizin performansını da iyileştirir.

Hassas içeriklerin korunması, web sitelerinin güvenliği açısından kritik bir unsurdur. Bu içerikler, kullanıcı verileri, finansal bilgiler veya özel belgeler gibi önemli bilgileri içerebilir. Bu tür içeriklerin korunması için erişim kontrolü ve şifreleme yöntemleri kullanılmalıdır.

Önbellekleme (Caching) ve İçerik Güncelliği

Önbellekleme stratejileri, içerik optimizasyonunda önemli bir rol oynar. Web sitelerinin hızlı yüklenmesine yardımcı olan önbellekleme (cache) mekanizması, kullanıcıların sayfaları daha hızlı açmasını sağlar. Ancak önbellekleme yaparken içerik güncelleme sıklığına dikkat etmek gerekir. Özellikle sık güncellenen içerikler için önbelleğin düzenli olarak temizlenmesi ve güncellenmesi önemlidir. Bu uygulama, kullanıcıların her zaman en güncel bilgilere ulaşmasını garantiler. Önbellek kullanımında, içeriğin güncelliği ile web sitesi performansı arasındaki dengeyi dikkatli bir şekilde yönetmek önemlidir.

Gelecek Trendler ve Hazırlık

Web teknolojilerindeki hızlı gelişim, yapay zeka tabanlı crawler'ların ve JavaScript işleme yeteneklerinin de sürekli evrim geçirmesine yol açıyor. Gelecekte, JavaScript işleme yeteneklerinin daha da gelişmesi bekleniyor. Bu durum, AI crawler'larının dinamik içerikleri daha etkin bir şekilde anlamasına olanak tanıyacak ve web sitelerinin içeriğini analiz etmelerini kolaylaştıracaktır. SSR ve SSG gibi yaklaşımların daha fazla benimsenmesi, içeriklerin daha erişilebilir ve taranabilir hale gelmesini sağlayacaktır.

Crawler verimliliğinde beklenen bu iyileşmeler, web sitelerinin SEO stratejilerini de derinden etkileyecek. AI tabanlı tarayıcıların daha gelişmiş algoritmalar kullanarak içerikleri daha hızlı ve doğru bir şekilde taraması, web yöneticilerinin içerik optimizasyonu sürecini kolaylaştıracaktır. Bu gelişmeler, web sitelerinin daha iyi indekslenmesine ve dolayısıyla kullanıcı deneyiminin artmasına önemli katkılar sağlayacaktır.

Yapay zeka (AI) modellerinin içerik anlama kapasitesindeki artış da önemli bir trend olarak öne çıkıyor. Gelecekte bu modellerin daha karmaşık ve detaylı içerikleri anlaması, analiz etmesi ve yorumlaması bekleniyor. Bu durum, web geliştiricilerin içeriklerini sunma biçimlerini dikkatlice değerlendirmelerini zorunlu kılacaktır.

Yapay zeka teknolojilerindeki hızlı gelişmeler, web standartlarını ve arama motoru algoritmalarını sürekli olarak evrimleştirmekte ve bu durum webmasterlar ve SEO uzmanları için sürekli öğrenme ve optimizasyon süreçlerini zorunlu kılmaktadır. Gelecekte, AI'nın içeriği anlama ve yorumlama yeteneklerinin gelişmesi, web sitelerinin başarısı için proaktif ve uyarlanabilir bir yaklaşımın önemini daha da artıracaktır. Bu nedenle, web geliştiricilerin ve SEO uzmanlarının bu değişimlere uyum sağlayarak, sürekli olarak öğrenmeye ve gelişmeye açık olmaları, dijital dünyadaki rekabette öne çıkmaları için hayati bir öneme sahip olacaktır.

Kaynak: https://vercel.com/blog/the-rise-of-the-ai-crawler